해군분석모델용 AI-CGF를 위한 시나리오 생성 모델 설계(I): 진화학습

Design of Scenario Creation Model for AI-CGF based on Naval Operations, Resources Analysis Model(I): Evolutionary Learning

Article information

Trans Abstract

Military training is an essential item for the fundamental problem of war. However, there has always been a problem that many resources are consumed, causing spatial and environmental pollution. The concepts of defense modeling and simulation and CGF(Computer Generated Force) using computer technology began to appear to improve this problem. The Naval Operations, Resources Analysis Model(NORAM) developed by the Republic of Korea Navy is also a DEVS(Discrete Event Simulation)-based naval virtual force analysis model. The current NORAM is a battle experiment conducted by an operator, and parameter values such as maneuver and armament operation for individual objects for each situation are evaluated. In spite of our research conducted evolutionary, supervised, reinforcement learning, in this paper, we introduce our design of a scenario creation model based on evolutionary learning using genetic algorithms. For verification, the NORAM is loaded with our model to analyze wartime engagements. Human-level tactical scenario creation capability is secured by automatically generating enemy tactical scenarios for human-designed Blue Army tactical scenarios.

기 호 설 명

Fitness: 적합도

ReachTarget: 목표지점도달여부

MOEWinRate: 교전승률

MOEBlueDamageRate: 청군피해율

MOERedDamageRate: 홍군피해율

1. 서 론

군사 훈련은 전쟁이라는 현실적 문제에 대해 필수적으로 요구되는 항목이다. 그러나 막대한 양의 자원이 소모되고 공간적·환경적 오염을 야기한다는 문제는 항상 존재해왔다[1]. 이 문제를 개선하기 위해 컴퓨터 기술을 활용한 국방 모델링 및 시뮬레이션(M&S, Modeling and Simulation)[2]과 가상군(CGF, Computer Generated Force)[2]의 개념이 등장하기 시작하였다.

미국의 OneSAF[3] 등으로 대표되는 가상군 M&S 모델은 전문가의 지식을 바탕으로 구축된 전문가 시스템 등의 규칙 기반 시스템으로 설계되었다.

대한민국 해군에 의해 개발된 해군분석모델(NORAM, Naval Operations, Resources Analysis Model)[4]도 DEVS (Discrete Event Simulation)[5] 기반의 전구급 해군분석모델로써, 한반도 전장/작전환경에 적합한 군 전술 교리를 반영한 작전/작계/무기체계 분석 및 전시자원 수요 산출이 가능한 한국형 분석모델이다[4].

함정무기체계의 발전과 지속적으로 변화하는 안보환경 및 미래 전력 변화에 따른 다양한 모의 전투실험 요구가 증대되어 오고 있다. 그러나 정보 부족으로 미래 위협(전술, 방책 등)의 예측이 제한되고 이에 따라 다양한 전술 모의를 통한 전투실험이 제한적이다. 또한 안보 환경 변화에 따른 다양한 방책 수립 및 운용 시 장시간의 인적 자원이 투입이 요구되며, 기 수집된 정보판단을 근거로 변화 요소들을 고려한 방책을 수집하려면 다양한 변수들에 대한 사전 분석 및 상호관계 검증이 필요하다.

현재의 해군분석모델은 운용자에 의해 전투실험이 진행되고 있으며, 상황별 개별 객체에 대한 기동, 무장 운용 등의 파라미터 값을 운용자가 세부적으로 입력해야 하는 상황이다. 따라서 아래와 같은 개선점에 대한 추가적인 보완이 이루어진다면 훨씬 성능이 향상될 것이다. 첫째, 기 수집된 정보판단에 근거한 방책 또는 전술 시나리오 적용. 둘째, 정보판단에 의거한 추론에 기반한 시나리오 운용. 셋째, 시나리오 생성 시 운용자의 경향성이 어느 정도 반영되어 객관성 유지가 제한적이다.

본 연구는 Fig. 1에 표시된바, 이러한 문제점을 개선하고자 첫째 모범답안 생성을 위한 진화학습, 둘째 일반화를 위한 지도 및 강화학습에 관해 연구를 진행하였다. 이 중 본 논문에서는 진화학습에 중점을 두어 설명하며, 지도 및 강화학습 연구 내용은 지면 관계상 후속 논문으로 제출한다. 본 논문에서는 진화학습 기반의 시나리오 생성 모델을 설계하며, 검증을 위해 해군에서 개발된 해군분석모델에 유전 알고리즘(GA, Genetic Algorithm)[6] 기반의 인공지능(AI, Artificial [7]을 탑재시켜 전구급 교전 분석을 진행 Intelligence) 하였다.

실험 결과 인공지능을 탑재한 홍군 전술이 기존의 청군 전술을 위협하는 고도의 전술 시나리오를 생성시킬 수 있음을 확인하였다. 본 연구 결과는 향후 전술 시뮬레이션 시 홍군 시나리오의 자동 생성뿐만 아니라 아군 전술의 발전에 기여할 수 있을 것으로 기대된다.

2. 해군분석모델용 AI-CGF를 위한 유전 알고리즘 기반 시나리오 생성 모델

해군분석모델용 AI-CGF를 위한 유전 알고리즘 기반 시나리오 생성 모델(이하 시나리오 생성 모델)의 전체 시스템 구조는 다음 Fig. 1과 같다. 시나리오 생성 모델은 운용자에 의해 사전 정의된 환경, 청군, MOE(Measures Of Effectiveness) 기반 적합도 시나리오를 바탕으로 다수의 최적 홍군 전술 시나리오를 제공한다.

운용자는 이를 통해 청군 전술의 제한점을 다양한 홍군 시나리오의 생성을 통하여 확인할 수 있으며 청군 방책 발전에도 기여할 수 있다.

시나리오 생성 모델은 아래의 과정을 통해 학습된 최적의 홍군 전술 시나리오를 생성한다.

2.1 유전자 설계

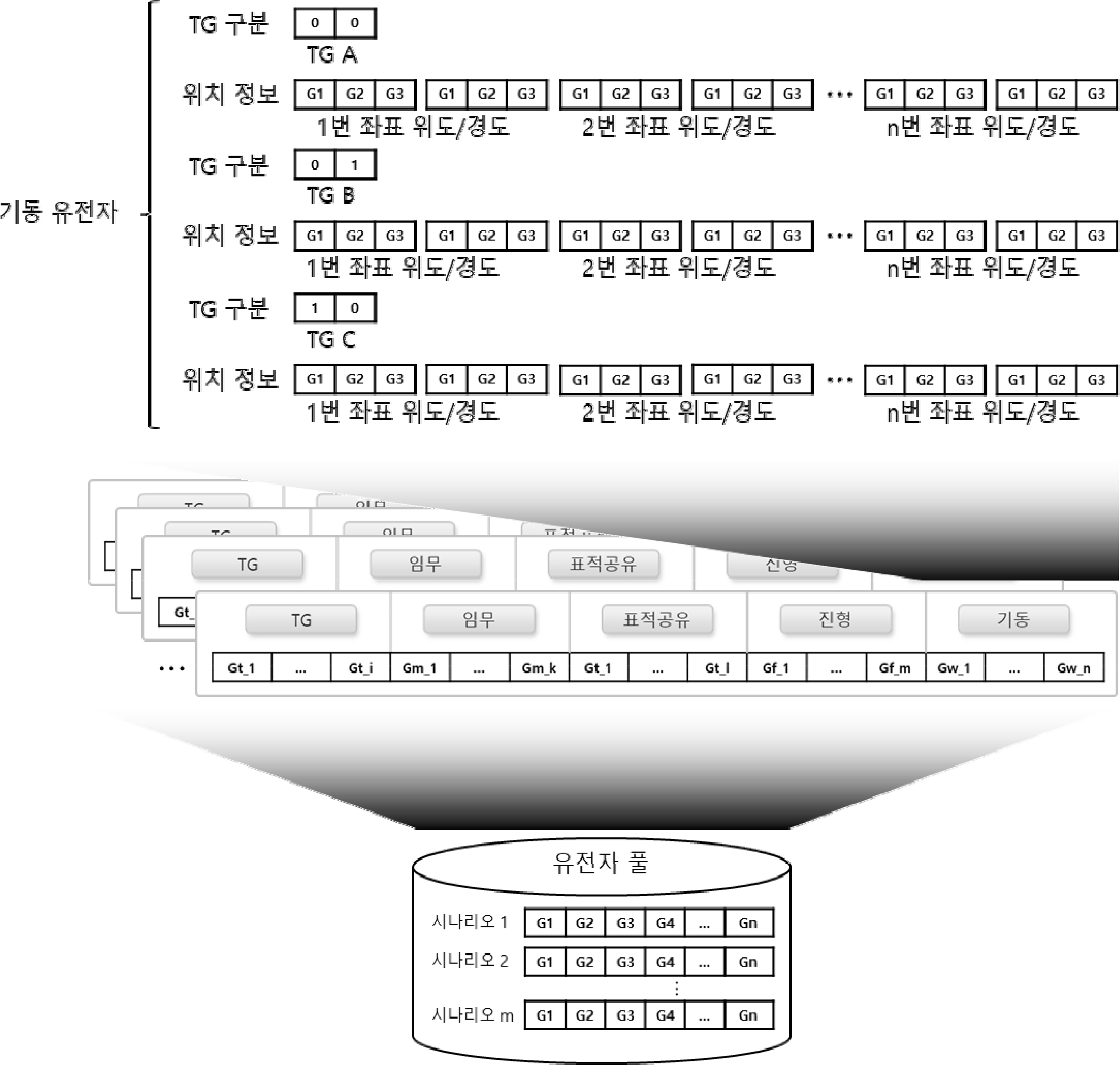

유전자의 각 개체는 해군분석모델의 홍군 전술 시나리오와 1:1로 매칭된다. 각 개체를 구성하는 유전자는 다음 Fig. 2와 같이 설계되었다.

유전자는 크게 TG(Task Group), 임무, 표적 공유 설정, 진형, 기동의 5가지 단위로 설정된다.

각 그룹에 대한 설계는 아래와 같다. TG는 해당 유전자가 어떤 TG인지를 명시한다. 임무는 해당 TG가 수행해야 할 임무를 나타낸다. 표적 공유는 다른 TG 와 표적을 공유할지 말지를 설정한다. 진형은 진형의 유형을 정한다. 기동은 기동의 종류를 결정한다.

허용 가능한 TG의 수는 세력에 포함된 함선의 수보다 작거나 같다.

전술 시나리오를 구성하는 유전자 중 기동 유전자를 예시로 상세히 설명한다. 기동 유전자는 크게 TG 구분과 해당 TG의 기동 경로점들로 구성된다. 이를 위해 비분리 기반 가변 유전자[8]를 적용하여 n개의 유전자가 자유롭게 생성/소멸하도록 구성하였다. 본 논문에서는 실험 소요 시간 절약을 위해 기동의 종류를 경로 기동으로 제한하였다.

2.2 유전자 풀

유전자 풀은 다음 Fig. 2와 같이 위에서 설계된 개체들로 구성된다.

2.3 진화학습 제어기

진화학습 제어기는 유전자 풀의 관리와 각 개체의 전술 시나리오 변환 및 진화학습 연산을 담당한다. 즉 유전자 풀에서 개체를 가져와 전술 시나리오로 변환 하여 몬테카를로 시뮬레이션 제어기에 전달하고, 이를 통해 도출된 개체별 적합도를 수집한다.

세대마다 모든 개체에 대한 적합도를 수집한 뒤 유전 연산을 진행하여 다음 세대에 적용할 유전자 풀을 생성한다.

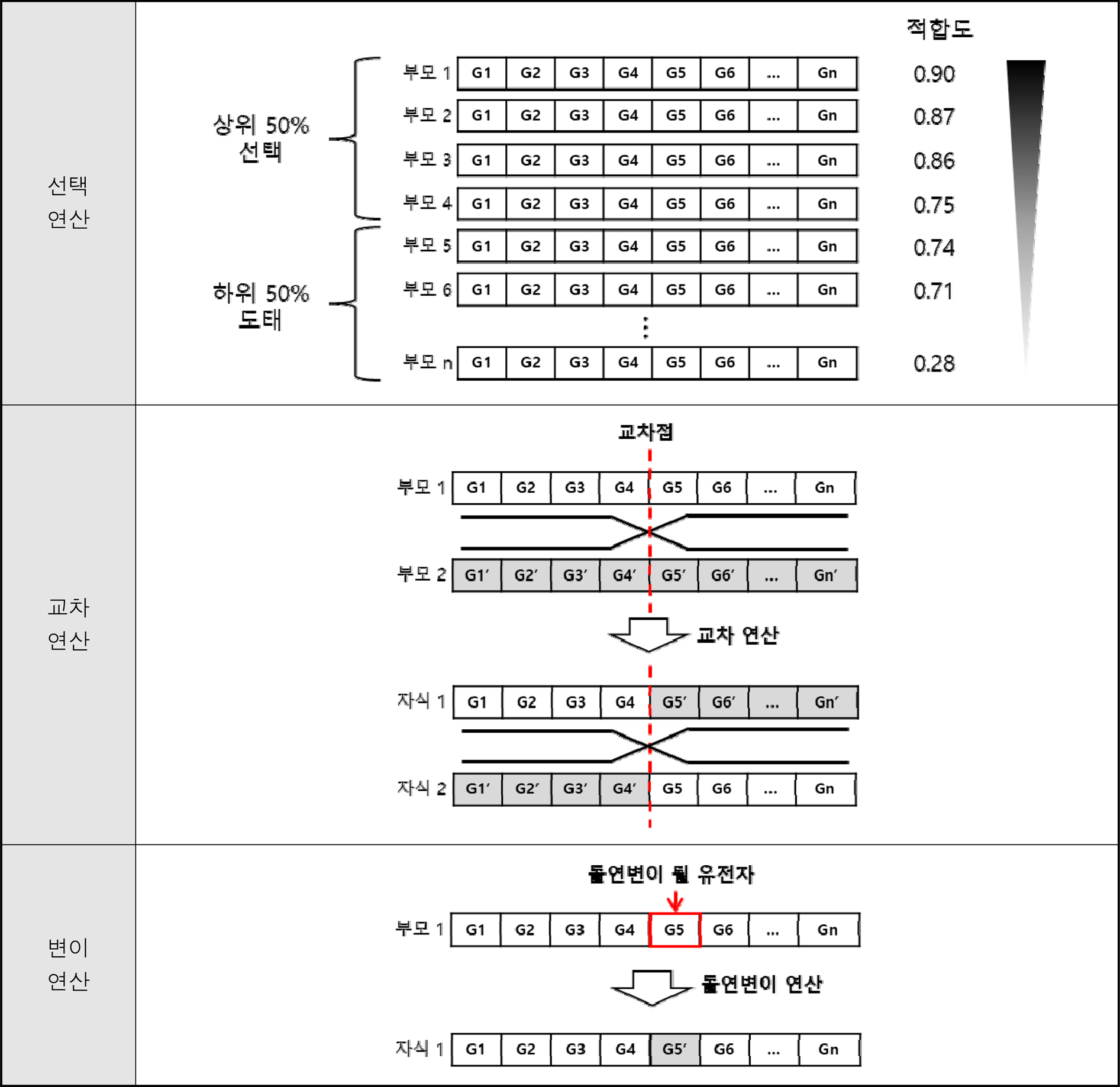

유전 연산은 현세대의 전체 개체를 적합도에 따라 오름차순으로 정렬한 후 다음 Table 1에서 표기한 선택, 교차, 변이의 순서로 진행한다.

2.3.1 선택 연산

선택 연산은 일정 비율의 적합도 상위 유전자를 선택하여 다음 세대로 전달하며, 나머지 하위 유전자는 도태시킨다.

2.3.2 교차 연산

교차 연산은 선택된 적합도 상위 개체들의 유전자를 부모로 하여 적용된다. 선택된 상위 유전자 2개체를 부모로 설정하여 자식을 생성하는데, 이때 임의의 교차점을 기준으로 삼는다.

2.3.3 변이 연산

변이 연산은 선택 연산과 교차 연산을 통해 생성된 개체들의 유전자를 대상으로 임의 개수의 유전자를 변이시키는 작업을 수행한다.

2.4 몬테카를로 시뮬레이션 제어기

확률 모델을 바탕으로 작동하는 해군분석모델의 특성상 확률에 의존하는 결과가 도출될 수 있기에 몬테카를로 시뮬레이션 제어기를 통해 몬테카를로 시뮬레이션[9]을 수행할 수 있도록 한다.

진화학습 제어기를 통해 전달된 홍군 전술 시나리오를 해군분석모델에 입력하기 위해 이미 전달된 청군 전술 시나리오, 환경 시나리오와 합쳐 전체의 분석 시나리오로써 해군분석모델에 전달된다.

이미 전달된 MOE 기반 적합도 시나리오를 통해 시뮬레이션마다 생성되는 MOE 결과를 분석하여 적합도로써 생성하며, 최종 몬테카를로 시뮬레이션이 끝난 후 각 적합도의 평균을 해당 홍군 전술 시나리오의 적합도 값으로 진화학습 제어기에 전달한다.

3. 시뮬레이션 결과

3.1 초기 조건 설정

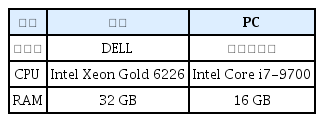

본 연구를 위한 컴퓨팅환경은 아래의 Table 2에서 정의된 사양의 서버 1대, PC 2대를 사용하였다.

본 논문에서는 실험에 드는 과도한 시간을 절약하면서 제안하는 모델의 타당성 검증을 위해 다른 진화학습을 이용한 워게임 논문들[10,11,12,13]을 참고하여 여러 제약 조건을 설정하였다. 첫째, 유전 알고리즘의 종료 조건을 위한 최대 세대 수를 100세대로 제한하였으며, 세대별 개체 수도 100개체를 유지하도록 설정하였다. 둘째, 홍군의 세력 구성비를 3:3:3 or 3:6 or 9로 제한하였다. 셋째, 홍군의 최대 TG 수를 3으로 제한하였다.

넷째, 실험에 적용한 몬테카를로 시뮬레이션 횟수는 수식 (1)의 오차범위 10 % 이내를 목표로 100회로 한정하였다.

위의 제약 조건을 적용하여 실험 시 1개의 청군 시나리오에 대응하는 최적의 홍군 시나리오를 생성하기 위해 약 1달의 시간이 소모되었는데, 이는 해군분석모델을 통해 반복모의하는 과정에서 전체 시간의 약 70 % 가 소요되었다.

본 논문에서는 실제 해군에서 사용하는 DB를 사용하지 못하고 가짜 DB를 통해 해군분석모델을 이용하였다. 청군과 홍군의 무장 세력이 대등하게 운용되도록 사전 검증을 진행하였으며, 검증 결과 청군은 6척의 수상함, 홍군은 9척의 수상함으로 설정하였을 때, 전면전의 경우에서 승률 50%가 나옴을 확인하였다.

홍군 TG 구성은 위의 Table 3과 같으며, 각 표기별(1:1:1, 1:2:0, 3:0:0) 세력은 유전자 풀에서 1/3씩의 할당되도록 조율하였다. TG 구성에 따른 효과도 분석을 위함이다.

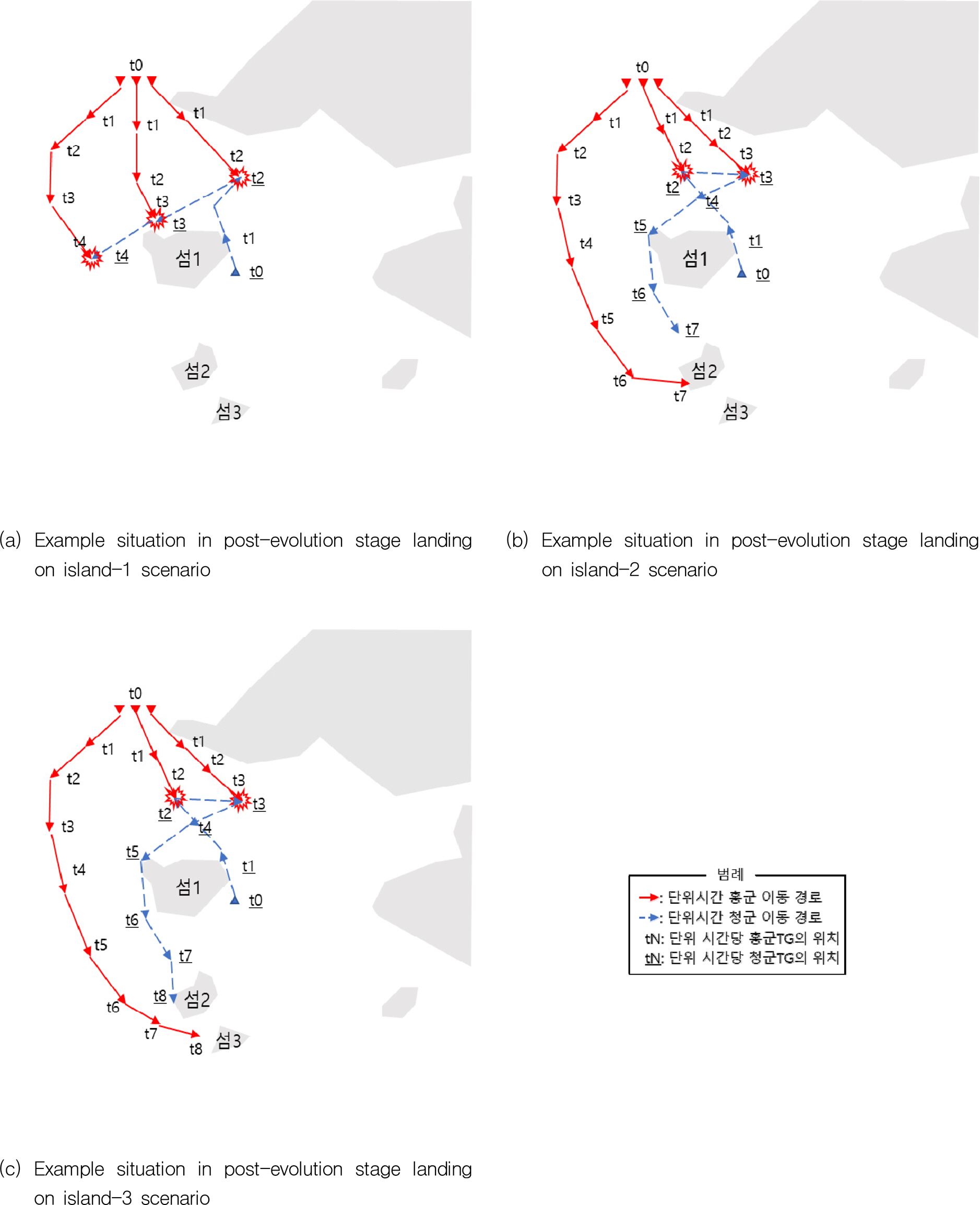

본 연구에서는 정해진 청군 시나리오에 대항할 수 있는 수준의 다음 Fig. 3과 같이 홍군 전술 시나리오를 자동 생성할 수 있음을 실험을 통해 보인다.

섬1 인근 해역을 기준으로 총 5개의 청군 전술 시나리오를 바탕으로 시뮬레이션을 진행하였으며, 각 전술 시나리오에서 청군은 섬1 인근에서 경계 임무를 수행하며, 홍군은 경계선 침범, 남하, 상륙(섬1, 섬2, 섬3) 등 다섯 가지 임무를 수행하도록 설정하였다. 본 논문에서는 지면 관계상 상륙전(Fig. 3)의 3개 전술 시나리오에 관해 설명한다.

상륙 시나리오는 목적 지점에 대한 상륙 여부를 주요 지표로 설정하였다. 이를 토대로 정립된 적합도는 다음 수식 (2)과 같다.

실험의 종료는 진화학습의 결과인 적합도가 수렴될 경우로 설정[11]하였다.

3.2 실험결과

본 실험에선 해군분석모델에 사전 정의된 청군 시나리오를 이용하여 다음 Fig. 3의 3가지 다른 목적지(섬1/섬2/섬3)을 가진 적합도 함수를 설정, 이에 따른 시뮬레이션을 수행하였다.

세력 구성은 위 Table 3과 같이 설정하였다. 실험 결과 중 1:1:1의 경우를 시나리오별로 아래와 같이 비교하였다.

실험 결과 섬2/섬3과 섬1 두 가지의 경향으로 분류되는 것을 이동 경로(Fig. 3 참조)와 적합도 분석(Fig. 4 참조)을 통해 확인할 수 있다.

다음 Fig. 4(b), (c)의 섬2/섬3의 경우 1:1:1의 TG 구성이 다른 세력 구성에 비해 높은 적합도를 보였는데, 2개의 TG를 미끼로 제공하는 전술을 구사한 것으로 분석된다. 청군은 미끼 TG와 교전 후 그사이 남하한 홍군 1개 TG를 추격하였으나 상륙을 저지하지는 못하였다.

반면, 섬1(Fig. 4(a))의 경우 앞선 섬2/섬3의 경우와 다르게 3:0:0의 TG 구성이 다른 세력 구성에 비해 높은 적합도를 보임을 확인할 수 있었다. 이는 섬1은 홍군 세력의 임무 시작 지점으로부터 남하하는 거리가 짧고 아군의 경계 임무 시작 지점과의 거리 또한 짧아 앞선 섬2/섬3의 미끼를 활용한 전략과는 다르게 전면전과 유사한 형태를 보이는 것으로 분석된다. 이 경우, 미끼를 통한 시간 확보보다는 정면 돌파를 통해 상륙 성공확률이 높게 나온 것으로 추정된다. 다만, 섬2/섬3과 섬1의 최고 적합도 수치를 비교하였을 때 정면 돌파의 경우 세력이 유사하지만 임무 성공률이 낮은 것을 확인할 수 있었다.

4. 결 론

본 논문은 진화학습을 적용한 해군분석모델용 AI-CGF를 위한 시나리오 생성 모델을 설계하였다. 제안된 모델은 유전자 풀, 진화학습 제어기, 몬테카를로 시뮬레이션 제어기를 통해 해군분석모델에 전술 시나리오를 전달함으로써 진화학습을 시작한다. 진화 과정에서 선택, 교배, 변이의 진화 연산이 적용되었다.

총 5가지의 청군 전술 시나리오에 대하여 제안된 진화학습을 실험한 결과 전술적 가치가 높은 홍군 전술 시나리오를 생성할 수 있었다. 다만, 구성한 세력 상에서 높은 적합도가 곧바로 홍군의 승리를 의미하지는 않는 것으로 확인되었다. 그런데도 상륙전의 경우 청군의 이동 경로를 길게 가져가도록 유인함으로써 상륙 목표를 성공적으로 달성하는 고도의 전술도 확인할 수 있었다.

본 논문은 해군분석모델용 AI-CGF에 진화학습을 최초로 적용하였다. 이를 통해 인간이 설계한 청군 전술 시나리오에 대한 홍군 전술 시나리오를 자동 생성함으로써 논리적이며 수준이 높은 전술 시나리오 생성 능력을 확보할 수 있었다.

진화학습을 이용한 시나리오 생성모델은 유전 알고리즘을 통해 최적의 시나리오를 생성할 수 있다는 장점을 갖고 있으나, 학습과정에서 과도한 시간이 소요된다는 단점 또한 갖고 있다. 이를 해결하기 위해 지도 및 강화학습을 활용한 시나리오 생성 모델에 관한 연구를 해군분석모델용 AI-CGF를 위한 시나리오 생성 모델 설계(II): 심층학습[14]에서 서술한다.

Acknowledgements

본 논문은 국방부 AI 빅데이터 공통기반 구축사업 예산으로 진행되었습니다. 지원에 감사드립니다.

현재 통제관에 의해 수행되는 시나리오 입력값 수정은 많은 시간이 소요되나 지능형 가상군 활용 시 입력 값 수정 과정의 자동화로 자원 소모를 획기적으로 줄일 수 있을 것이다. 아울러 워게임/분석모델 및 통합훈련체계와 연동하여 운영 시 단기간에 다양한 가상 세력의 구현으로 신뢰성 높은 분석이 가능할 것으로 기대된다.

제안된 AI-CGF는 홍군의 방책/전술 수립을 위한 행동 규칙을 학습함으로써 최적의 전술적 대안을 분석하는 데 크게 일조할 것으로 기대된다.