MWIR 및 SWIR 센서를 이용한 커널상관필터기반의 표적추적

Target Tracking based on Kernelized Correlation Filter Using MWIR and SWIR Sensors

Article information

Trans Abstract

When tracking small UAVs and drone targets in cloud clutter environments, MWIR sensors are often unable to track targets continuously. To overcome this problem, the SWIR sensor is mounted on the same gimbal. Target tracking uses sensor information fusion or selectively applies information from each sensor. In this case, parallax correction using the target distance is often used. However, it is difficult to apply the existing method to small UAVs and drone targets because the laser rangefinder's beam divergence angle is small, making it difficult to measure the distance. We propose a tracking method which needs not parallax correction of sensors. In the method, images from MWIR and SWIR sensors are captured simultaneously and a tracking error for gimbal driving is chosen by effectiveness measure. In order to prove the method, tracking performance was demonstrated for UAVs and drone targets in the real sky background using MWIR and SWIR image sensors.

1. 서 론

군사적인 목적의 감시정찰을 위해 전자광학추적시스템(EOTS: Electro-Optical Tracking System)이 많이 사용된다. 이 시스템에서 대공표적을 탐지, 추적하기 위해 주로 사용되는 카메라는 MWIR(Mid-Wave Infrared)[1–4] 이다.

그리고 관측을 목적으로 가시광 영상센서가 함께 사용되는 경우가 많다. 그러나 구름 클러터 환경에서 장시간 추적 유지가 필요한 대공무기 응용분야에서는 MWIR 센서와 함께 구름 혹은 안개 환경에서 좋은 특성을 갖는 SWIR(Short Wave Infrared)[5,6] 영상센서를 함께 장착한다. Fig. 1은 파장별 대기투과율을 나타낸 그래프이다. 이미징 시스템에서 가시광(VIS) 및 SWIR 카메라는 태양이나 지상의 빛에 의해 방출된 빛이 표적에 맞고 반사된 것을 검출하는 것이다[6]. 한편 절대온도 0도 이상의 모든 물체는 광자를 스스로 방출한다. 이 자체 방출된 광자를 검출하여 영상화하는 것이 MWIR 및 LWIR 카메라이다. 따라서 MWIR 및 LWIR 카메라는 빛이 없는 야간에도 표적을 관측할 수 있는 장점이 있다. SWIR 카메라는 표적에 맞고 반사되는 태양빛을 감지하여 영상화하는 특성 때문에 야간에는 사용할 수 없으나 연무 및 안개를 투과하는 능력이 우수하고 표적의 재질에 따른 반사된 광자의 차이로 표적의 세부적인 형상정보를 얻는 것이 가능하다.

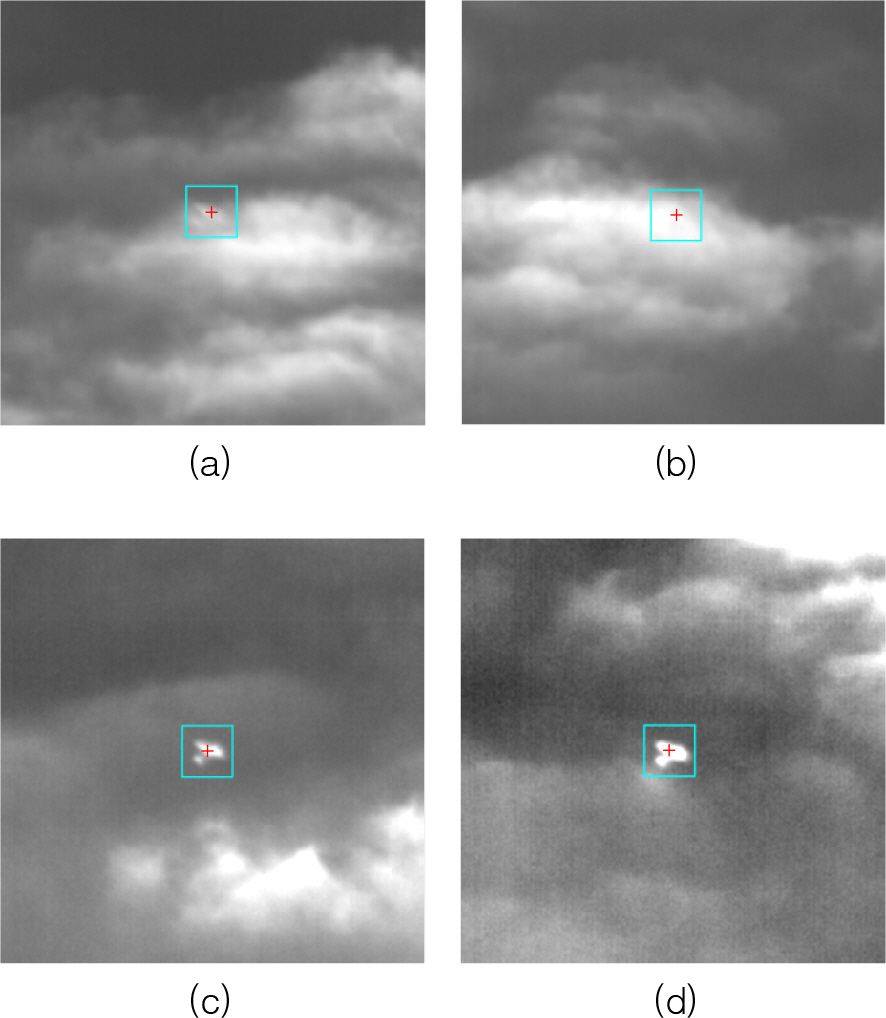

Fig. 2는 동일 짐벌에 장착된 두 센서를 이용하여 대공표적의 영상을 동시에 획득한 것이다. Fig. 2에서 보인 것처럼 대공표적이 구름 속으로 들어갈 경우 MWIR 영상에서는 표적을 구별할 수 없으나 SWIR 영상에서는 표적이 잘 구분될 수 있음을 알 수 있다. (a)에서 표적을 검은색 화살표로 표시하였다.

다중 영상센서를 활용한 추적 방법에서 기존의 방법은 영상센서의 시계가 동일할 경우 다중 영상을 영상정합(image registration) 방법을 사용하거나 영상센서의 장착위치에 따라 발생하는 시차(Parallax)를 거리에 따라 보정하여 추적정보를 융합하는 방법이다[7–9]. 그러나 표적이 수 km 이상 먼 거리에 있고, 표적이 소형표적의 경우 체계에 장착되어있는 거리측정기를 이용하여 거리를 측정할 때 정확한 거리를 측정하기 어렵다. 그 이유는 거리측정기의 빔 발산각이 작고 클러터에 의한 오측정 확률 때문이다. 이 경우 시차를 고려한 융합추적 방법은 성능이 떨어진다.

제안 방법을 구현하기 위한 시스템은 한 개의 짐벌에 MWIR 센서와 SWIR 센서를 장착하고 있고, 두 센서로부터 영상이 동기화되어 병렬적으로 영상신호처리기에 동시에 입력된다. 각 센서별로 각각의 영상처리보드를 내장하고 있어 병렬적으로 신호처리가 가능하다. 그리고 두 센서의 시계(FOV: Field Of View)는 광시계(Wide FOV), 협시계(Narrow FOV)의 2 개의 시계를 가지고 있다고 가정한다. 제안 방법의 장점은 표적이 구름 클러터에 가려져 있어 MWIR 영상센서의 추적결과가 유효하지 않을 경우 SWIR 영상센서의 추적결과로 짐벌을 구동하고, MWIR 및 SWIR 영상이 모두 가려져 있어서 두 센서의 추적결과가 모두 유효하지 않을 경우는 MWIR 영상을 이용한 재탐지(Re- detection) 과정을 수행하여 표적을 재포착 후 추적할 수 있다. 제안한 방법은 MATLAB을 이용하여 구현하였으며, 하늘 배경에서 대공표적에 대해 획득한 3개 영상 데이터에 적용하여 유효성을 입증한다.

2. 센서 선택 추적

제안하는 추적 방식에는 단일센서 추적이 기본적으로 수행된다. 단일센서 추적은 MWIR(파장 : 3~5 µm) 및 SWIR(파장 : 0.9~1.7 µm) 센서가 동일 짐벌에 장착되어 있을 경우 영상 갱신주기 별로 구동기로 전송되는 추적오차에 한 개의 영상센서 추적오차를 이용하는 모드이다. 이 추적모드는 주추적기(Main tracker: MWIR 을 의미 함)로 입력되는 영상(MWIR)에서 표적의 구분이 어려울 경우 추적점 유효성 판단기준이 임계치 이하로 낮아진다. 이때 부추적기(Sub-tracker) 입력영상(SWIR) 추적결과로 짐벌구동을 수행하여 구름클러터 환경에서도 연속적으로 표적추적을 가능하게 한다. Fig. 3은 주추적기 및 부추적기의 연동 다이어그램이다. 통제컴퓨터에서 발생된 동기신호에 따라 MWIR 및 SWIR 카메라를 이용해 독립적으로 영상이 획득되면 영상처리기로 영상이 전송되고 2 개의 추적처리보드에서 독립적으로 MWIR 및 SWIR 추적영상처리 알고리즘이 동작한다. MWIR 및 SWIR 추적점 계산 결과는 MWIR 추적처리보드에서 취합되고 유효성 판단기준에 따라 유효한 추적오차를 짐벌제어기로 전송한다.

추적기의 수행절차는 KCF(Kernelized Correlation Filter)[10]를 기반으로 한다. 두 센서에서의 추적결과가 모두 양호할 경우(추적점 유효의 경우) 주 추적기 추적오차(차선 중심과 추적점 간의 픽셀 거리)로 짐벌을 구동하고, 부 추적기는 입력되는 SWIR 영상을 기반으로 병렬적으로 영상추적을 수행한다. 부 추적기는 동시에 각 프레임 별로 차선의 중심과 표적 중심간의 거리를 최소화할 수 있도록 차선을 미세하게 이동(예를들어, 0.1픽셀) 시켜서 표적추적이 진행될수록 표적의 중심에 차선(reticle) 중심을 일치시킨다.

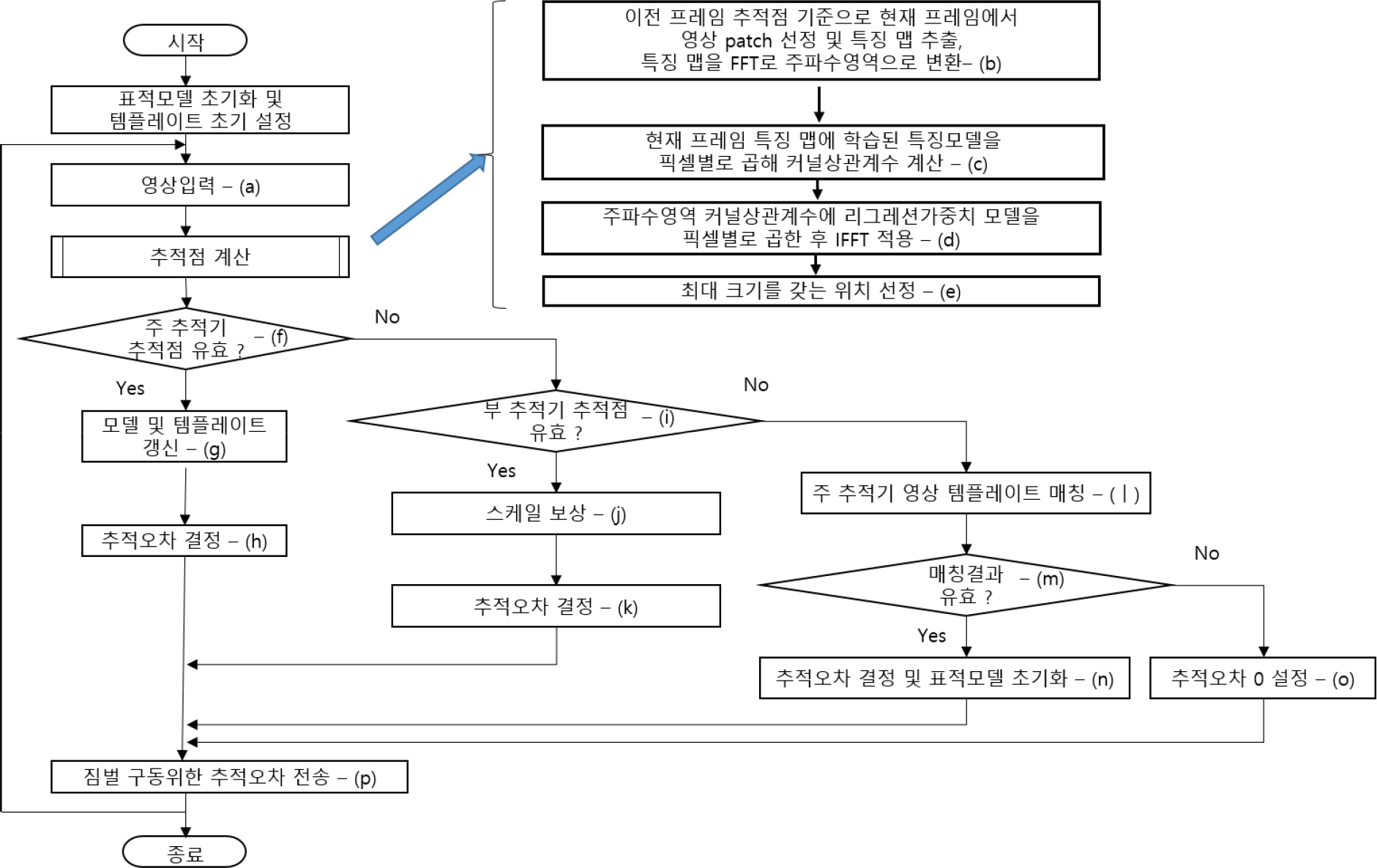

2.1 주추적기 추적

Fig. 4는 단일센서 추적에서 주추적기의 추적알고리즘 흐름도이다. 알고리즘을 세부적으로 설명하면 다음과 같다. 표적탐지 단계에서 표적위치가 지정되었다고 가정한다. 추적모드가 선택되면 첫 번째 프레임에서 표적 모델 및 표적 템플레이트를 초기화하고 다음과 과정을 순차적으로 수행한다.

(a) 카메라로부터 영상을 입력 받는다.

(b) 입력된 영상에서 이전 프레임 표적위치 기준으로 에서 영상패치를 설정한 후(예, 64 × 64 픽셀) 특징을 추출한다. 사용된 특징은 3 × 3 sobel 필터[11]로 에지를 추출한 후 에지의 크기를 특징으로 사용한다. 특징맵(영상패치의 에지크기 맵)을 FFT(Fast Fourier Transform)로 주파수 영역으로 변환한다.

(c) 현재 프레임 특징맵과 학습된 특징모델[10]을 픽셀별로 곱하여 주파수영역에서의 커널상관계수(Kernel Correlation Coefficient)를 계산한다. 학습된 특징(표적)모델은 추적 시작부터 현재프레임까지 추적점 계산결과를 기반으로 Fig. 4의 절차 (g)에 의해 매 프레임별로 갱신되는 것이다. 이전 프레임들의 특징맵 및 현재 프레임의 특징맵의 가중합으로 정의[10]한다.

(d) 커널상관계수와 리그레션 가중치 모델[10]을 주파수영역에서 픽셀별 곱셈을 통해 커널상관계수를 계산한 후 IFFT(Inverse Fast Fourier Transform)을 계산한다.

(e) 상관계수 맵에서 최대 크기를 갖는 픽셀 위치를 현재 프레임의 예비 추적점으로 결정한다.

(f) 주추적기의 예비추적점이 2.3 추적점 유효성 판단을 이용하여 유효한지 판단한다.

(g) 유효할 경우 예비 추적점을 기준으로 특징 모델, 리그레션 계수 및 표적 템플레이트를 갱신한다.

(h) 차선(영상에서의 짐벌 중심 위치)을 기준으로 추적오차를 결정한다. 단계 (p)로 이동한다.

(i) 주추적기의 예비 추적점이 유효하지 않을 경우 부추적기의 예비 추적점은 유효한지 판단한다.

(j) 부추적기의 예비추적점이 유효할 경우 식 (5)를 이용하여 픽셀 추적오차에 IFOV(Inverse Field of View)를 이용하여 스케일 보상을 한다.

(k) 추적오차를 결정한다. 단계 (p)로 이동한다.

(l)주추적기 및 부추적기의 예비추적점 모두 유효하지 않을 경우는 설정된 표적 템플레이트를 주추적기의 현재 영상 프레임에 매칭시켜서 표적을 재탐지(Re-detection) 한다. 템플레이트 매칭은 영상 공간영역에서 NCC(Normalized Cross Correlation)[11]를 이용한다. 표적 템플레이트는 (g) 단계에서 주추적기의 유효한 추적점을 기준으로 갱신된 특징맵 (에지 크기맵) 이다.

(m) 템플레이트 매칭 결과 최대 상관계수를 갖는 픽셀 위치에서 추적점 유효성 판단한다.

(n) 추적점이 유효할 경우는 추적오차를 결정하고 표적모델을 초기화한다.

(o) 주추적기, 부추적기 및 주추적기 영상의 NCC 결과가 모두 유효하지 않을 경우는 추적오차를 0으로 결정한다. 이것은 짐벌의 현재 위치를 유지하는 것을 의미 한다.

(p)짐벌 구동기로 추적오차를 전송한다.

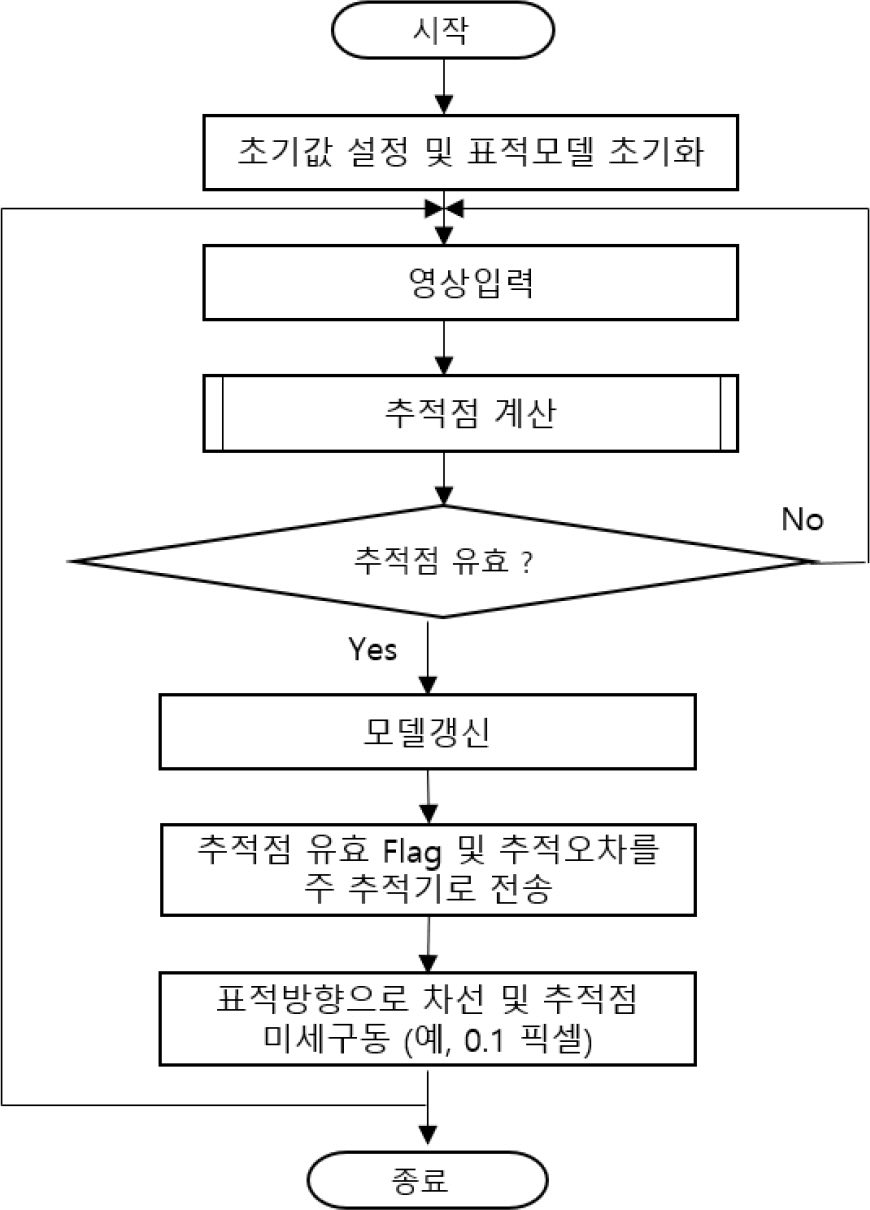

2.2 부추적기 추적

부추적기에 사용되는 영상정보는 SWIR(단파장 적외선) 카메라로 부터 입력되는 영상으로 동일한 표적을 다른 파장의 카메라로 획득한 정보이다. Fig. 5는 부추적기의 수행절차를 나타낸다. 이것은 SWIR 입력영상을 기반으로 영상추적을 수행한다. 부추적기의 추점점계산 절차는 주추적기의 경우와 동일한 절차를 따른다. 부 추적기는 동시에 각 프레임 별로 차선의 중심과 표적 중심간의 거리를 최소화할 수 있도록 차선과 추적점을 미세하게 이동(예를들어, 0.1픽셀) 시켜서 표적추적이 진행될수록 표적의 중심에 차선을 일 치시킨다. Fig. 6은 표적 중심으로 차선을 밀어주는 절차이다. Fig. 6에서 SOE(Sum of Edge) 구할 때의 에지의 합을 구하는 방법은 관심픽셀 주변 15 × 15(표적의 크기에 따라 가변 가능) 윈도우의 에지합을 구해 관심 픽셀값을 채워 넣는 방식이다[12]. 주 추적기의 추적 결과가 양호하지 않을 경우(추적점이 유효하지 않을 경우)는 부 추적기의 추적오차(차선중심과 추적점 간의 픽셀 거리)로 짐벌을 구동함으로써 주 추적기가 추적할 수 없는 경우에도 표적추적을 유지할 수 있다.

2.3 추적점 유효성 판단

추적점 유효성 판단은 두 가지 측정 수단이 사용된다. 예비 추적점(상관계수 값이 최대인 픽셀 위치)[10]의 PSR(Peak to Sidelobe Ratio)[13]이 임계값 이상이고 동시에 TBR(Target Background Ratio)이 임계값 이상이면 추적점이 유효한 것으로 확정한다. 식 (1)과 같이 정의된 현재 프레임 영상패치에서의 PSR과 식 (2)와 같이 정의된 영상패치에서의 TBR이 적용된다. 식 (1) 에서 gmax는 표적의 위치를 찾는 상관계수 맵에서 최대 상관계수 값이며, μsl, σsl은 사이드로브 영역의 평균과 표준편차이다. 사이드로브 영역은 gmax 위치를 기준으로 11 × 11 픽셀(실험적으로 정한 크기로 변경 가능)을 제외한 영역이다.

if μt ≥ μbg

식 (2)에서 μt, μbg는 표적영역 및 배경영역에서의 sobel edge 크기의 평균이다. 식 (2)에서 표적영역은 최대 상관계수 값을 갖는 위치를 중심으로 관심영역 설정 후 Fig. 6의 표적영역 찾는 절차(가장 큰 영역을 표적으로 찾는 절차)를 수행한 것이다. 배경영역은 그 외 영역이다. 수식 (3)은 PSR 및 TBR을 이용하여 정의한 유효성(Effectiveness) 측정 수단 Ek를 정의한 것으로 현재 영상 프레임 k에서의 추적점 유효성 Ek를 PSRk 및 TBRk의 곱으로 정의한다.

식 (4)는 각 영상 프레임에 계산된 유효성에 따라 현재 프레임의 유효한 추적점인지를 판단하는 것이다. 식 (4)에서 ThE는 유효성의 임계값이며 μE는 유효한 추적점에 대해서만 계산된 Ek의 평균값이다. 그리고 c1은 경험적으로 선택된 상수 값 (예, 0.6) 이다. 현재 프레임이 k 일때 Ek가 ThE 보다 크면 현재 프레임의 추적점이 유효하다고 판단한다. 주추적기의 추적점이 유효하지 않아 부추적기의 결과를 이용할 경우 부추 적기 영상에서 구해진 추적오차 (픽셀단위)

IFOVM, IFOVS는 주추적기 및 부추적기의 IFOV (Instantaneous Field of View)로서 영상 1 픽셀이 나타내는 각도 이다. ifovM, ifovS는 IFOVM와 IFOVS 중 큰 값으로 정규화한 값이다. 추적기 및 부추적기의 영상 크기 및 시계가 동일할 경우는 ifovS / ifovM = 1 이다.

3. 실험 및 분석

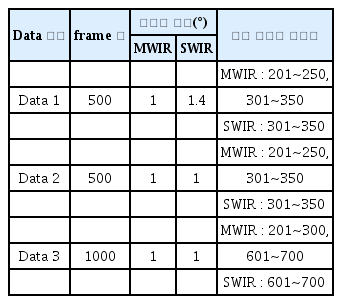

실험에 사용한 영상은 한 개의 짐벌에 장착되어 있는 MWIR 및 SWIR 카메라에서 시간적으로 동기화된 영상을 동시에 저장한 것으로 3 개의 영상 세트를 이용하여 실험하였다. 실제 구름 클러터 환경에서의 표적은 고정익 무인기이며 표적거리는 1.5~3.2 km 이다. Table 1은 영상 데이터에 대한 설명이다.

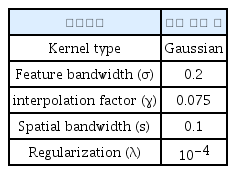

첫 번째 프레임에서는 표적을 에워싼 사각형을 표시해준다. 실제 시스템에서는 표적탐지 단계에서 탐지 장치에 의해 표적의 위치가 추적장치로 보내진다. 이것은 추적을 시작하기 위한 사전지식이다. 추적에서는 입력된 영상에서 이전 프레임 추적점 기준으로 정해진 영상패치에 3 × 3 Sobel 연산자를 이용해 에지를 구한 후 에지 크기를 특징으로 사용하였다. Table 2는 실험에서 사용한 커널상관필터의 파라메타[10]를 설명한 것이다. 영상 Data 1에서 MWIR 및 SWIR 영상이 각 500 프레임으로 구성되어 있다. MWIR 카메라가 주추적기로 사용되었으며 시계는 1°이고, SWIR 카메라는 부추적기로 사용되었으며 시계는 1.4° 이다. 영상의 크기는 400 × 400 픽셀이다. 1~200 프레임에서는 표적이 구름 사이를 지나고 있으나 50~70 프레임까지는 표적과 구름의 대비가 좋지않다. 71~200 프레임은 중간 정도의 수준으로 두 영상에서 표적의 위치를 어느정도 구분할 수 있는 수준이다. 201~250 프레임 까지는 MWIR 영상에서는 표적이 100 % 가려진 상태이며, SWIR 영상에서는 표적식별이 가능하다. 251~300 프레임은 두 영상에서 모두 표적 구분이 가능한 영상이며, 301~350 프레임에서는 MWIR 및 SWIR 영상에서 모두 표적이 가려져 있다. 351~ 500 프레임에서는 두 영상에서 모두 표적 구분이 가능하다.

Fig. 7은 실험영상 Data 1에 대해 제안한 추적방법을 적용한 결과이다. 표적 추적에 MWIR 및 SWIR 영상이 모두 사용되었으며, 주추적기가 MWIR로 선택되어 있어서 추적 결과를 MWIR 영상에 보였다. Fig. 7에서 빨간색 십자선은 제안방법이 적용된 추적점 계산결과이며, 하늘색 사각형은 추적점을 기준으로 설정된 영상패치를 도시한 것이다. 표적의 Fig. 7(a)는 50 번째 프레임으로 MWIR 및 SWIR 영상에서의 추적결과가 유효하여 MWIR 추적결과가 사용되고, (b)는 210번째 프레임으로 MWIR 영상에서의 추적 유효성 판단결과가 임계값 보다 낮아 SWIR 영상에서의 추적결과를 시계 보정을 통해 계산한 결과가 도시된 것이다. (c)는 351번째 프레임 추적결과 이다. 301~350는 프레임에서 표적이 모두 가려져있어 추적 결과가 모두 유효하지 않아 NCC를 이용한 템플레이트 매칭 알고리즘이 동작하지만 추적 유효성 판단 결과가 임계값 보다 낮아 추적오차를 0으로 전송한다. 351 번째 프레임에서 표적이 나타나 NCC 를 이용한 템플레이트매칭에 의해 표적이 재탐지된 결과이다. 352 번째 프레임부터는 다시 Fig. 4의 알고리즘이 다시 동작한다. 그림 (d)는 최종적으로 500 번째 프레임의 추적결과이다. 500 번째 프레임에서 빨간색 십자선이 표적의 중심 근처에 놓여있는 것으로 보아 표적추적이 잘 수행되고 있음을 알 수 있다. 추적 성능을 객관적으로 평가하기 위해 입력영상에서 표적을 에워싼 사각형을 수동으로 표시하고 알고리즘에 의한 추적 결과와 비교하였다.

Tracking result for single tracking in MWIR data (a) 50th frame, (b) 210th frame, (c) 351th, (d) 500th frame

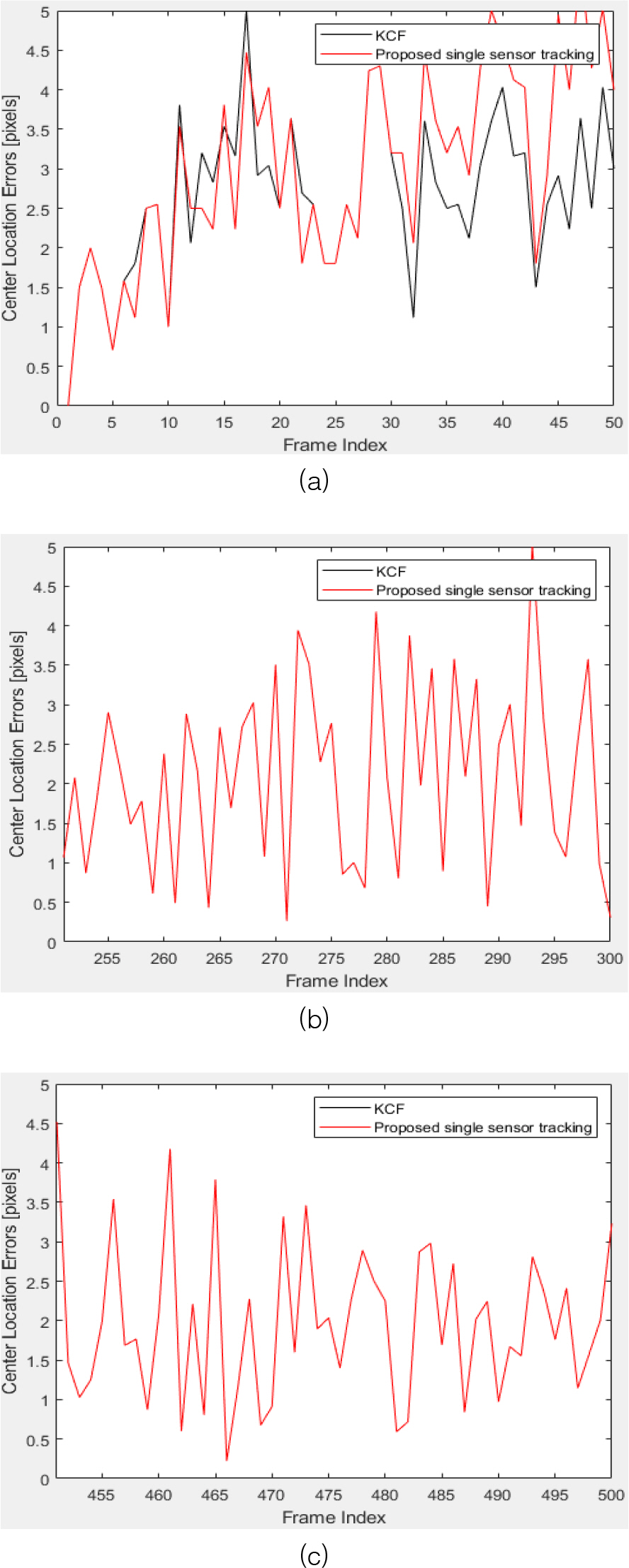

1~50번째 프레임, 251~300번째 프레임 및 451~500번째 프레임에서 표적의 위치를 수동으로 표시하고 ground truth로 사용하였다. 추적 알고리즘의 성능지표로서 많이 사용되는 CLE(Center Location Error)[4]는 영상에서 표적의 ground truth 중심과 알고리즘에 의해 추정된 중심 간의 거리로 정의한다. 따라서 CLE가 작을수록 정확한 추적이 가능하다. 기존의 HOG 특징을 사용한 KCF 추적기[10]와 제안방법을 비교한 것을 Fig. 8에 그래프로 도시하였다. Fig. 8에서 가로축은 영상프레임 번호이며 세로축은 CLE 이다. 1~50 번째 프레임의 경우 MWIR 영상에 표적이 양호하게 보이는 경우로 Table 3과 같이 KCF에서는 평균 CLE가 3.1 픽셀 이었으며 제안방법의 경우는 CLE가 3.0 수준이었다. 그러나 201번째 프레임부터는 표적이 보이지 않기 때문에 KCF 방법으로는 추적오차가 발산하여 추적이 불가능 하지만 제안한 방법으로는 SWIR 영상을 이용하여 추적이 가능하였다. 301~350 프레임에서 두 영상에서 모두 표적이 보이지 않다가 351 프레임 이후에 표적이 다시 보이면 재탐지과정을 거쳐서 다시 추적이 가능함을 보여주고 있다. Ground truth가 존재한 프레임에 대해 제안한 방법의 평균 CLE는 2.4픽셀로 계산되었다.

Tracking results by center location errors: (a) 1th~50th frame, (b) 251th~300th frame, (c) 451th~500th frame

Table 4는 실험에 사용된 영상 데이터 3 세트에 대한 평균 CLE를 나타내고 있다. 3 개의 데이터 모두에 대해 3 픽셀 미만의 양호한 추적성능 보였다.

추적점 유효성 판단을 위해 사용된 식 (4)에서 가중치 c1이 추적성능에 미치는 영향을 분석하기 c1을 0.5~1.0 까지 변화시키면서 Table 1의 영상 데이터 3 개에 평균 CLE의 변화를 Fig. 9에 나타냈다. 실험결과, c1이 0.5~0.75인 경우에 3개의 데이터 모두에서 추적성능의 변화가 크지 않음을 알 수 있었다. 영상에 따라 PSR 및 TBR의 값이 변할 수 있으며, 식 (4)에서 μE가 적응적으로 변함으로써 임계값 가중치 c1에의 변화에는 민감하지 않음을 알 수 있다. 그러나 가중치가 0.8 이상일 경우 추적성능이 감소하였다. Table 4의 성능은 c1 = 0.6인 경우의 추적성능을 나타낸다.

4. 결 론

이 논문에서는 MWIR 영상 및 SWIR 영상을 사용하여 구름 클러터 환경에서 안정적으로 표적을 추적하기 위한 추적 방법을 제안하였다. 두 가지 영상에서의 추적 정보 중에서 유효성 판단기준에 따라 추적점을 결정함으로써 구름 클러터 변화에 잘 적응하여 안정된 추적 결과를 얻을 수 있다. 기존의 다중 영상센서 융합 방법에서는 영상정합 방법이나 시차보정 과정이 필요하지만 제안방법은 위 과정이 필요하지 않은 장점이 있다. 제안한 방법의 유효성을 입증하기 위해 실제 운용환경에서 획득한 3 개의 영상 세트에 제안한 방법을 적용하여 효용성을 입증하였다. 이 추적방법은 실제 무인기 대응체계의 추적 및 조준시스템에 적용이 가능하다.