[1] Daeki Kim and Youngse Mun, "An Evaluation on the Military Force in Neighboring Countries of Korea," KJPAE, Vol. 16, No. 1, pp. 139‚Äď65, 2006.

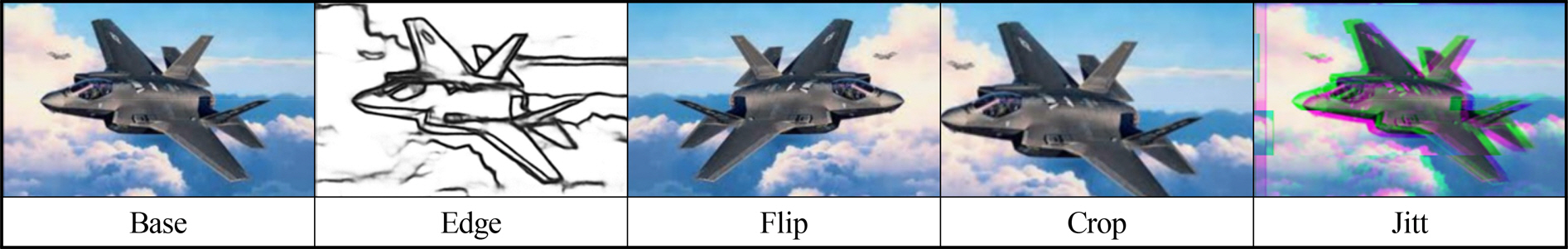

[2] Connor Shorten and Taghi M. Khoshgoftaar, "A Survey on Image Data Augementation for Deep Learning," Journal of Big Data, Vol. 6, Article Number 60. 2019.

[3] Dongsuk Park, Seungeui Lee, SeongUk Park and Nojun Kwak, "Radar-Spectrogram-Based UAV Classification Using Convolutional Neural Networks," MDPI Sensors, Vol. 21, No. 1, pp. 210‚Äď227, 2021.

[4] Jeonghwan Kim, Jinyoung Park and Hoseok Moon, "The Study on the Model for Detection and Classification of Multinational Warship Using Deep Learning," Journal of the Military Operations Research Society of Korea, Vol. 46, No. 2, pp. 73‚Äď83, 2020.

[5] Kaiming He, Xiangyu Zhang, Shaoqing Ren and Jian Sun, Deep Residual Learning for Image Recognition, arXiv:1512.03385. 2015.

[6] Mingxing Tan and Quoc V. Le, EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks, arXiv:1905.11946. 2019.

[7] Xavier Soria, Edgar Riba and Angel Sappa, Dense Extreme Inception Network: Towards a Robust CNN Model for Edge Detection, arXiv:1909.01955. 2020.

[8] Salem Saleh Al-Amri, N. V. Kalyankar and S. D. Khamitkar, "Image Segmentation by Using Edge Detection," International Journal on Computer Science and Engineering, Vol. 2.3, pp. 804‚Äď807, 2010.

[9] X.-Y. Gong, H. Su, D. Xu, Z.-T. Zhang, F. Shen and H.-B. Yang, "An Overview of Contour Detection Approaches," International Journal of Automation and Computing, Vol. 15, pp. 656‚Äď672, 2018.

[10] Yoshua Bengio, Aaron Courville and Pascal Vincent, "Representation Learning: A Review and New Perspectives," IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 35.8, pp. 1798‚Äď1828, 2013.

[11] Myeongsuk Pak and Sanghoon Kim, A Review of Deep Learning in Image Recognition, 2017 4th International Conference on Computer Applications and Information Processing Technology(CAIPT). pp. 1‚Äď3, 2017.

[12] Andrew G. Howard, Menglong Zhu, Bo Chen, Dmitry Kalenichenko, Weijun Wang, Tobias Weyand, Marco Andreetto and Hartwig Adam, MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications, arXiv:1704.04861. 2017.

[13] Olga Russakovsky, Jia Deng, Hao Su, Jonathan Krause, Sanjeev Satheesh, Sean Ma, Zhiheng Huang, Andrej Karpathy, Aditya Khosla, Michael Bernstein, Alexander C. Berg and Li Fei-Fei, "ImageNet Large Scale Visual Recognition Challenge," International Journal of Computer Vision, Vol. Volume 115, pp. 211‚Äď252, 2015.

[14] Jo Plested, Xuyang Shen and Tom Gedeon, Rethinking Binary Hyperparameters for Deep Transfer Learning for Image Classification, arXiv: 2107.08585v2. 2021.

[15] Christian Szegedy, Sergey Ioffe, Vincent Vanhoucke and Alex Alemi, Inceptionv4, Inception-ResNet and the Impact of Residual Connections on Learning, arXiv:1602.07261. 2016.

[16] Subhransu Maji, Esa Rahtu, Juho Kannala, Matthew Blaschko and Andrea Vedaldi, Fine-Grained Visual Classification of Aircraft, arXiv:1306.5151. 2013.