[1] S. W. Park, H. S. Park, Y. B. Kim and D. G. Kim, "Suspected Object Detection and Tracking methods for National Defence Surveillance," Communications of the Korean Institute of Information Scientists and Engineers, Vol. 36, No. 8, pp. 33‚Äď40, 2018.

[2] D. W. Choi and J. M. Ma, "Improvement of Ship Classification Based on Artificial Neural Network Considering Night and Low Visibility Marine Environment," Korean Journal of Computational Design and Engineering, Vol. 24, No. 3, pp. 320‚Äď328, 2019.

[3] J. W. Lee, D. W. Nam and W. Y. Yoo, "A Study on Composition of Warship Type/Class Identification System," The Korea Institute of Information and Communication Engineering, Vol. 23, No. 2, pp. 607‚Äď610, 2019.

[4] M. A. Jeong and J. M. Ma, "Improvement of Submarine Detection Based on Mast Images Using An Ensemble Model of Convolutional Neural Networks," Journal of the Korea Institute of Military Science and Technology, Vol. 23, No. 2, pp. 115‚Äď124, 2020.

[5] Log0. Class Imbalance Problem, August 30, 2013;http://www.chioka.in/class-imbalance-problem/. (accessed July 10, 2020.)..

[6] H. He and E. A. Garcia, "Learning from Imbalanced Data," IEEE Transactions On Knowledge And Data Engineering, Vol. 21, No. 9, pp. 1263‚Äď1284, 2009.

[7] S. B. Kim, Sampling Technique for Analysis of Imbalanced Data, February 20, 2020;https://www.youtube.com/watch?v=Vhwz228Vrlk. (accessed June 28, 2020.)..

[8] H. S. Jeong, C. W. Kang and K. K. Kim, "The Effect of Oversampling Method for Imbalanced Data," Journal of The Korean Data Analysis Society, Vol. 10, No. 4, pp. 2089‚Äď2098, 2008.

[9] K. N. Lee, J. T. Lim, K. S. Bok and J. S. Yoo, "Handling Method of Imbalance Data for Machine Learning: Focused on Sampling," The Korea Contents Society, Vol. 19, No. 11, pp. 567‚Äď577, 2019.

[10] H. C. Kim, Adversarial Cost-Sensitive Learning for Class Imbalance Problem, M. E. Thesis, University of Gangwon. 2020.

[11] T. Fawcett, Learning from Imbalanced Classes, August 25, 2016;https://www.svds.com/learning-imbalanced-classes/. (accessed July 10, 2020.)..

[12] J. O. Kim, E. S. Hwang and J. M. Yoo, "Analysis of NCO Promotion Factors Using Imbalanced Data Processing," 12th International Army Modeling & Simulation Education Conference, pp. 902019.

[13] Solaris. "Deep Learning to Learn by Tensorflow," Youngjin.com, Seoul, 2018.

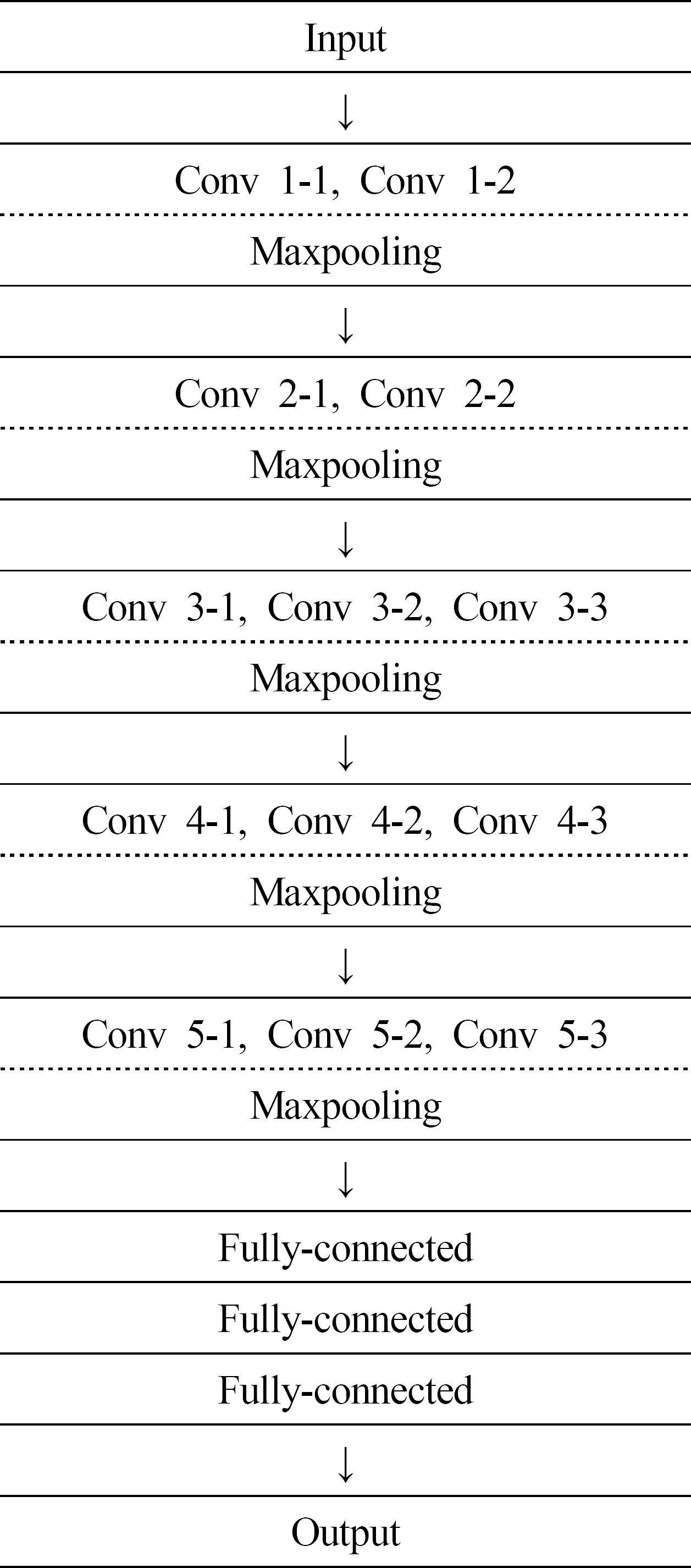

[14] K. Simonyan and A. Zisserman, "Very Deep Convolutional Networks for Large-Scale Image Recognition," International Conference on Learning Representations, pp. 1‚Äď14, 2015.

[15] G. Saito, "Deep Learning from Scratch," Hanbit Media, Seoul, 2017.

[16] J. Brownlee, How to Develop a Cost-Sensitive Neural Network for Imbalanced Classification, February 2, 2020;https://machinelearningmastery.com/cost-sensitive-neural-network-for-imbalanced-classification/. (accessed May 2, 2021.)..

[17] S. J. Yoo et al, "Analysis of Big-Data Using Python," The Twenty-First Century, Paju, 2018.

[18] M. K. Seo, "Practical Data Processing and Analysis Using R," Gilbut Publishing, Seoul, 2014.