[1] L. M. Novak et al, "The Automatic Target-Recognition System in SAIP," Linc. Lab. J., Vol. 10, No. 2, pp. 187–202, 1997.

[2] R. Hummel, Model-based ATR Using Synthetic Aperture Radar, in Proc. IEEE Radar Conf., Alexandria, VA, USA. 2000.

[3] Q. Zhao et al, "Support Vector Machines for SAR Automatic Target Recognition," IEEE Trans. Aerosp. Electron. Syst., Vol. 37, No. 2, pp. 643–654, Apr. 2001.

[4] Y. J. Sun et al, "Adaptive Boosting for SAR Automatic Target Recognition," IEEE Trans. Aerosp. Electron. Syst., Vol. 43, No. 1, pp. 112–125, Jan. 2007.

[5] M. David, Deep Convolutional Neural Networks for ATR from SAR Imagery, Proc. SPIE, Algorithms for Synthetic Aperture Radar Imagery XXII. 2015.

[6] O. Kechagias-Stamatis et al, "Fusing Deep Learning and Sparse Coding for SAR ATR," IEEE Trans. Aerosp. Electron. Syst., Vol. 55, No. 2, pp. 785–797, Apr. 2019.

[7] S. Chen et al, "Target Classification Using the Deep Convolutional Networks for SAR Images," IEEE Trans. Geoscience and Remote Sensing, Vol. 54, No. 8, pp. 4806–4817, 2016.

[8] Z. Lin et al, "Deep Convolutional Highway Unit Network for SAR Target Classification with Limited Labeled Training Data," IEEE Geosci. Remote Sens. Lett., Vol. 14, No. 7, pp. 1091–1095, Jul. 2017.

[9] F. Zhou et al, "SAR ATR of Ground Vehicles based on LM-BM-CNN," IEEE Trans. Geosci. Remote Sens., Vol. 56, No. 12, pp. 7282–7293, Dec. 2018.

[10] R. Xue et al, "Spatial-Temporal Ensemble Convolution for Sequence SAR Target Classification," IEEE Trans. Geosci. Remote Sens., Vol. 59, No. 2, pp. 1250–1262, Feb. 2021.

[11] Z. Cui et al, "Image Data Augmentation for SAR Sensor via Generative Adversarial Nets," IEEE Access, Vol. 7, pp. 42255–42268, 2019.

[12] Q. Yu et al, "High-Performance SAR Automatic Target Recognition Under Limited Data Condition based on a Deep Feature Fusion Network," IEEE Access, Vol. 7, pp. 165646–165658, 2019.

[13] J. Hu et al, Squeeze-and-Excitation Networks, in Proc. IEEE Comput. Soc. Conf. Comp. Vis. Pattern Recognit., Salt Lake City, UT, USA. 2018.

[14] L. Wang et al, "SAR ATR of Ground Vehicles based on ESEnet," Remote Sens., Vol. 11, No. 1316, pp. 1–16, 2019.

[15] J. H. Park et al, "SAR ATR for Limited Training Data Using DS-AE Network," Sensors, Vol. 21, No. 4358, pp. 1–19, 2021.

[16] M. Zhang et al, Convolutional Nerual Network with Attention Mechanism for SAR Automatic Target Recognition, IEEE Geosci. Remote Sens. Lett., Early Access.2020.

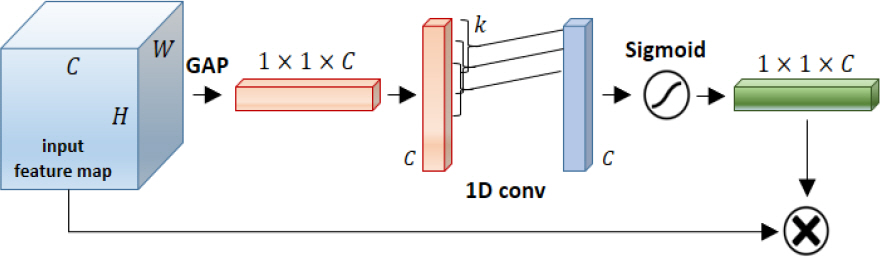

[17] Q. Wang et al, ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks, in Proc. IEEE Comput. Soc. Conf. Comp. Vis. Pattern Recognit., Virtual Conference. 2020.

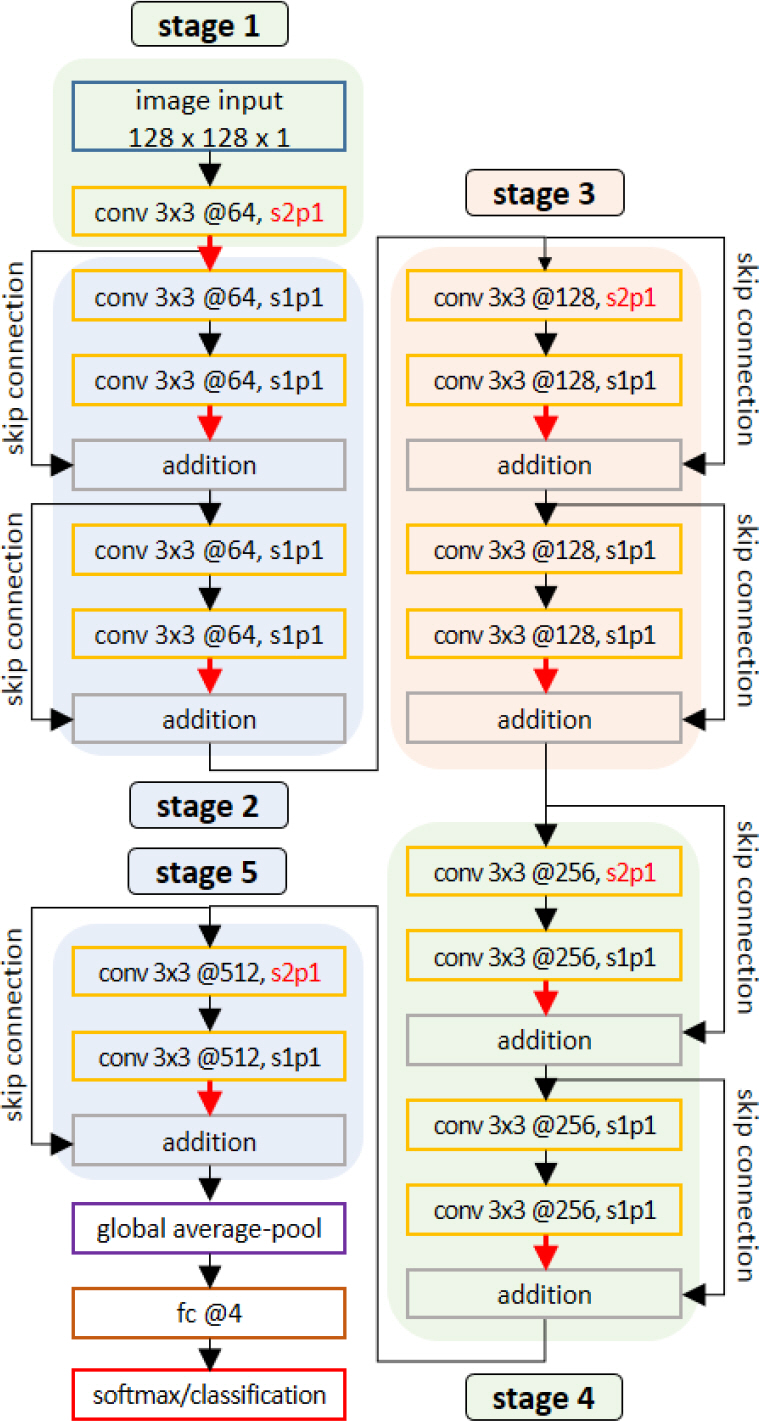

[18] K. He et al, Deep Residual Learning for Image Recognition, in Proc. IEEE Conf. Comput. Vis. Pattern Recognit.(CVPR), pp.pp. 770–778, Jun. 2016.

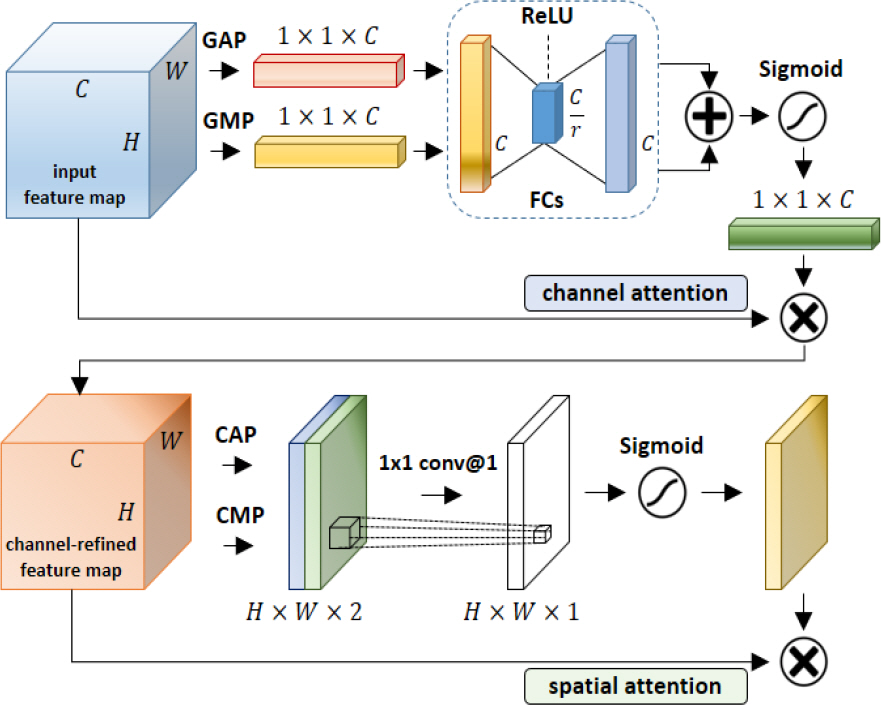

[19] S. Woo et al, CBAM: Convolutional Block Attention Module, in Proc. Eur. Conf. Comput. Vis., pp.pp. 3–19, 2018.

[20] O. Kechagias-Stamatis et al, SAR ATR by a Combination of Convolutional Neural Network and Support Vector Machines, IEEE Aerosp. Electron. Syst. Mag., pp.pp. 56–81, Mar. 2021.