|

|

- Search

| J. KIMS Technol > Volume 26(5); 2023 > Article |

|

Abstract

This research paper investigates the effectiveness of using computer graphics(CG) based synthetic data for deep learning in military vehicle detection. In particular, we explore the use of synthetic image generation techniques to train deep neural networks for object detection tasks. Our approach involves the generation of a large dataset of synthetic images of military vehicles, which is then used to train a deep learning model. The resulting model is then evaluated on real-world images to measure its effectiveness. Our experimental results show that synthetic training data alone can achieve effective results in object detection. Our findings demonstrate the potential of CG-based synthetic data for deep learning and suggest its value as a tool for training models in a variety of applications, including military vehicle detection.

API: Application Programming Interface

CG: Computer Graphics

DL: Deep Learning

DR: Domain Randomization

GAN: Generative Adversarial Networks

NR: Neural Rendering

Ļ░Øņ▓┤ĒāÉņ¦Ć(Object Detection) ļ░Å ņŗ¼ņĖĄņŗĀĻ▓Įļ¦Ø ņĀüļīĆņĀü Ļ│ĄĻ▓®(Adversarial Attack) ļō▒ņØś ļöźļ¤¼ļŗØ(DL) ņŚ░ĻĄ¼ļź╝ ņ£äĒĢ┤ņä£ļŖö ĒśäņŗżņäĖĻ│äņŚÉņä£ ļ░£ņāØĒĢśļŖö ļŗżņ¢æĒĢ£ ņāüĒÖ®ņØä ļŗżļŻ░ ņłś ņ׳ļŖö ņłśņ▓£ņŚÉņä£ ņłśņ▓£ļ¦īĻ░£ņØś ļĀłņØ┤ļĖöļ¦ü(Labeling)ļÉ£ Ļ│ĀĒÆłņ¦łņØś ļīĆĻĘ£ļ¬© ĒĢÖņŖĄ ļŹ░ņØ┤Ēä░ļź╝ ĒĢäņÜöļĪ£ ĒĢ£ļŗż. ņŗżņĀ£ ļŹ░ņØ┤Ēä░ņØś ļĀłņØ┤ļĖöļ¦üņØĆ ļöźļ¤¼ļŗØ ņĢīĻ│Āļ”¼ņ”ś ĒĢÖņŖĄņØä ņ£äĒĢ┤ Ļ╝Ł ĒĢäņÜöĒĢ£ Ļ│╝ņĀĢņØ┤ņ¦Ćļ¦ī, ņØ┤ļ¤¼ĒĢ£ ņĀæĻĘ╝ļ░®ņŗØņØĆ ļīĆĻĘ£ļ¬© ĒĢÖņŖĄņÜ® ļŹ░ņØ┤Ēä░ņØś ĒÖĢļ│┤ņÖĆ ļ¦ÄņØĆ ļ╣äņÜ®Ļ│╝ ņŗ£Ļ░äņØ┤ ņåīņÜöļÉśļŖö ļĀłņØ┤ļĖöļ¦üņŚÉ ļīĆĒĢ£ ļ╣äņÜ®Ļ░Éļé┤Ļ░Ć ĒĢäņÜöĒĢśļŗż. ņØ┤ņŚÉ ļö░ļØ╝ ņĄ£ĻĘ╝ ļöźļ¤¼ļŗØ ņĢīĻ│Āļ”¼ņ”śņØś Ļ░£ļ░£ņØä ļ│┤ļŗż ļŹö ļ╣Āļź┤Ļ│Ā ĒÜ©ņ£©ņĀüņ£╝ļĪ£ ņłśĒ¢ēĒĢśĻĖ░ ņ£äĒĢ£ ļ░®ņĢłņØś ĒĢśļéśļĪ£ ņ╗┤Ēō©Ēä░ ņŗ£ļ«¼ļĀłņØ┤ņģśņØ┤ļéś ļöźļ¤¼ļŗØ ņĢīĻ│Āļ”¼ņ”śņØä ĒåĄĒĢ┤ ļŹ░ņØ┤Ēä░ļź╝ ņāØņä▒ĒĢśļŖö Ļ░ĆņāüļŹ░ņØ┤Ēä░(Synthetic Data) ņāØņä▒ ļ░Å ņ×ÉļÅÖ ļĀłņØ┤ļĖöļ¦ü ņĀæĻĘ╝ļ░®ņĢłņŚÉ ļīĆĒĢ£ ņŚ░ĻĄ¼[1Ōł╝5]Ļ░Ć ĒÖ£ļ░£Ē׳ ņ¦äĒ¢ēļÉśĻ│Ā ņ׳ļŗż.

Ļ░ĆņāüļŹ░ņØ┤Ēä░(ļśÉļŖö ĒĢ®ņä▒ļŹ░ņØ┤Ēä░)ļŖö ņŗżņĀ£ ļŹ░ņØ┤Ēä░ļź╝ ļ¬©ļ░®ĒĢ£ ļŹ░ņØ┤Ēä░ļĪ£ ņØĖĻ│ĄņĀüņ£╝ļĪ£ ņāØņä▒ļÉśņ¢┤ ņŗżņĀ£ņäĖĻ│äņØś ņé¼Ļ▒┤ņØ┤ļéś ņé¼ļ¼╝ņØä ĻĘ╝ņé¼ņĀüņ£╝ļĪ£ ļ░śņśüĒĢśļŖö ļ¬©ļōĀ ļŹ░ņØ┤Ēä░ļź╝ ļ¦ÉĒĢ£ļŗż[1,2]. Ļ░ĆņāüļŹ░ņØ┤Ēä░ļŖö ļŹ░ņØ┤Ēä░ņŚÉ ļĀłņØ┤ļĖöņØä ņłśļÅÖņ£╝ļĪ£ ņ¦ĆņĀĢĒĢśņ¦Ć ņĢŖņĢäļÅä ļīĆĻĘ£ļ¬©ļĪ£ ļöźļ¤¼ļŗØņÜ® ĒĢÖņŖĄļŹ░ņØ┤Ēä░ļź╝ ņāØņä▒ĒĢĀ ņłś ņ׳Ļ▒░ļéś ĻĘ£ņĀ£ ļīĆņāü ļŹ░ņØ┤Ēä░ ļśÉļŖö ļ»╝Ļ░É ļŹ░ņØ┤Ēä░ņØś ņé¼ņÜ®Ļ│╝ Ļ┤ĆļĀ©ļÉ£ ņĀ£ĒĢ£ ņé¼ĒĢŁņØä ņżäņØ╝ ņłś ņ׳ļŖö ļō▒ņØś ņŻ╝ņÜö ņןņĀÉņØ┤ ņ׳ņ£╝ļ®░ Ļ░ü ņé¼ņÜ®ņ×É ņāüĒÖ®ņŚÉ ļ¦×ļÅäļĪØ ļŹ░ņØ┤Ēä░ļź╝ ļ¦×ņČżĒśĢņ£╝ļĪ£ ņĀĢņØśĒĢĀ ņłś ņ׳ļŗż.

ĻĄŁļ░®ļČäņĢ╝ņØś Ļ▓ĮņÜ░ ļČäņĢ╝ņØś ĒŖ╣ņłśņä▒ņØä Ļ░ÉņĢłĒĢĀ ļĢī ļīĆĻĘ£ļ¬© ĒĢÖņŖĄņÜ® ļŹ░ņØ┤Ēä░ņØś ĒÖĢļ│┤Ļ░Ć ņ¢┤ļĀżņÜ┤ Ļ▓ĮņÜ░Ļ░Ć ļīĆļČĆļČäņØ┤ļ®░, Ļ░£ļ░£Ļ│╝ņĀĢņØś ņŗĀņåŹņä▒ ļ│┤ņןņØä ņ£äĒĢ┤ ņŗ£Ļ░ä ņåīņÜöĻ░Ć ļ¦ÄĻ│Ā ņé¼ļ×īņØś Ļ░£ņ×ģņØ┤ ĒĢäņÜöĒĢ£ ņłśļÅÖļ░®ņŗØ ļĀłņØ┤ļĖöļ¦üņŚÉ ļ¦ÄņØĆ ņĀ£ņĢĮņØ┤ ļ░£ņāØĒĢ£ļŗż. ļśÉĒĢ£ ņłśļÅÖ ļĀłņØ┤ļĖöļ¦üņØś ņśżļźś ļśÉļŖö Fig. 1ņŚÉņä£ņÖĆ Ļ░ÖņØ┤ Ļ░Ćļ”╝(Occlusions) ļō▒ņŚÉ ļö░ļźĖ ļČłņÖäņĀäĒĢ£ ņĀĢļ│┤ļĪ£ ņØĖĒĢ┤ ĒĢÖņŖĄ ļŹ░ņØ┤Ēä░Ļ░Ć ļČĆņĀĢĒÖĢĒĢ┤ņ¦ł Ļ░ĆļŖźņä▒ļÅä ņ׳ļŗż. ĒŖ╣Ē׳ ņ×Éņ£©ņŻ╝Ē¢ēņØś Ļ▓ĮņÜ░ ņłśļ¦ÄņØĆ ņ×Éņ£©ņŻ╝Ē¢ēņ░©ļ¤ēĻ│╝ ĒģīņŖżĒŖĖ ļō£ļØ╝ņØ┤ļ▓äĻ░Ć ļŹ░ņØ┤Ēä░ ĒÜŹļōØņØä ņ£äĒĢ┤ ņłśņ▓£ Ēé¼ļĪ£ļ»ĖĒä░ ņØ┤ņāüņØä ņÜ┤ņĀäĒĢ┤ņĢ╝ ĒĢśĻ│Ā Fig. 1ņŚÉņä£ņÖĆ Ļ░ÖņØĆ ĒŖ╣ņłśĒĢ£ Ļ▓ĮņÜ░(ĻĖ░Ēøä/ĒÖöņ×¼/ņé¼Ļ│Ā)ļōżņŚÉ ļīĆĒĢ£ ļ│äļÅäņØś Ļ│ĀļĀż ļō▒ ļ¦żņÜ░ ņ¢┤ļĀĄĻ│Ā ļ¦ÄņØĆ ļģĖļĀźņØ┤ ņåīņÜöļÉśļŖö ņØ╝ļĀ©ņØś ĒĢÖņŖĄļŹ░ņØ┤Ēä░ ĻĄ¼ņČĢĻ│╝ņĀĢņØ┤ ĒĢäņÜöĒĢśļŗż. Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś ĒÖ£ņÜ®ņØĆ ņØ┤ļ¤¼ĒĢ£ ĒĢÖņŖĄņÜ® ļŹ░ņØ┤Ēä░ ĻĄ¼ņČĢņŚÉ ļīĆĒĢ£ ļīĆņĢłņØä ņĀ£Ļ│ĄĒĢĀ ņłś ņ׳ņ£╝ļ®░, ņØ┤ļ¤¼ĒĢ£ ļŹ░ņØ┤Ēä░ ņāØņä▒ļ░®ņŗØņØĆ ņ¦üņĀæ Ļ░ĆņāüņØś ļŹ░ņØ┤Ēä░ļź╝ ņāłļĪŁĻ▓ī ņāØņä▒(Generation)ĒĢśļŖö ļ░®ļ▓ĢĻ│╝ ĻĖ░ņĪ┤ņØś ņŗżņĀ£ļŹ░ņØ┤Ēä░ņŚÉ ĒŖ╣ņĀĢļ░®ņŗØņØś ļ│ĆĒśĢņØä Ļ░ĆĒĢ┤ ņ”ØĻ░Ģ(Augmentation)ņŗ£ĒéżļŖö ļ░®ļ▓Ģ ļō▒ Ēü¼Ļ▓ī ļæÉ Ļ░Ćņ¦ĆļĪ£ ļéśļłī ņłś ņ׳ļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ĒĢÖņŖĄņÜ® ļŹ░ņØ┤Ēä░ ņāØņä▒ĒÖśĻ▓ĮņØś ņĀ£ņ¢┤ņÖĆ ĒÖĢņןņØ┤ ņÜ®ņØ┤ĒĢ£ 3ņ░©ņøÉ ļ¬©ļŹĖļ¦üĻ│╝ Ļ│ĀņåŹ ĻĘĖļלĒöĮ ļĀīļŹöļ¦ü ĻĖ░ņłĀņØä ņé¼ņÜ®ĒĢśņŚ¼ ļöźļ¤¼ļŗØ ĒĢÖņŖĄņÜ® ņØ┤ļ»Ėņ¦Ć ļŹ░ņØ┤Ēä░Ļ░Ć ņĀäĒśĆ ņĪ┤ņ×¼ĒĢśņ¦Ć ņĢŖļŖö ĒŖ╣ņłśĒĢ£ ņāüĒÖ®ņØä ņĀäņĀ£ļĪ£ ļ¼╝ņ▓┤ĒāÉņ¦Ć ļ¬©ļŹĖņØś ĒĢÖņŖĄņÜ® Ļ░Ćņāü ņØ┤ļ»Ėņ¦Ć ļŹ░ņØ┤Ēä░ ņāØņä▒ ļ░Å ļöźļ¤¼ļŗØ ĒĢÖņŖĄļČäņĢ╝ ņĀüņÜ®ņØä ņ£äĒĢ£ ļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ņłĀĻ│╝ Ļ┤ĆļĀ©ĒĢ£ ĻĖ░ņłĀņĀü Ļ▓ĆĒåĀņÖĆ ļČäņäØņØä ņłśĒ¢ēĒĢśĻ│Āņ×É ĒĢśņśĆļŗż. ļśÉĒĢ£ ņŗżņĀ£ ĒÖśĻ▓ĮņŚÉņä£ ĻĄ¼ĒśäĒĢśĻĖ░ ņ¢┤ļĀżņÜ┤ ņŚ¼ļ¤¼ Ļ░Ćņ¦Ć ņĪ░Ļ▒┤ņØä Ļ░ĆņāüĒÖśĻ▓ĮņŚÉņä£ ĻĄ¼ĒśäĒĢśņŚ¼ Ļ░Øņ▓┤ĒāÉņ¦Ćļ¬©ļŹĖņŚÉ ļīĆĒĢ£ ņĀüļīĆņĀü Ļ│ĄĻ▓® ļ¬©ļŹĖĻ░£ļ░£ņØä ņłśĒ¢ēĒĢśļŖö ņŗ£ļ«¼ļĀłņØ┤ņģś ņĀüņÜ®ņŚ░ĻĄ¼ļÅä ĒĢ©Ļ╗ś ņłśĒ¢ēĒĢśĻ│Āņ×É ĒĢśņśĆļŗż.

Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢśļŖö ļöźļ¤¼ļŗØ ņŚ░ĻĄ¼ļČäņĢ╝ņØś Ļ░Ćņן Ēü░ ņ¢┤ļĀżņøĆņØĆ ņŗżņĀ£ļŹ░ņØ┤Ēä░ņÖĆ Ļ░ĆņāüļŹ░ņØ┤Ēä░ Ļ░äņØś ļŹ░ņØ┤Ēä░ ļČäĒżņ░©ņØ┤ņØĖ ļÅäļ®öņØĖ Ļ░Ł(Domain Gap)[1]ņØ┤ļØ╝Ļ│Ā ĒĢĀ ņłś ņ׳ļŗż. ņØ┤ņŚÉ ļö░ļØ╝ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņŚ░ĻĄ¼ļČäņĢ╝ļŖö ņŗżļ¼╝ ļŹ░ņØ┤Ēä░ļČäĒżļź╝ ņל ļ¬©ņé¼ĒĢśĻĖ░ ņ£äĒĢ£ 1) Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ņłĀĻ│╝ Ļ░ĆņāüļŹ░ņØ┤Ēä░Ļ░Ć ņŗżļ¼╝ ļŹ░ņØ┤Ēä░ņŚÉ ļīĆĒĢ┤ ņל ļÅÖņ×æĒĢĀ ņłś ņ׳ļÅäļĪØ Ļ░ĆņāüĻ│╝ ņŗżņĀ£ ļŹ░ņØ┤Ēä░Ļ░äņØś ļÅäļ®öņØĖ ņ░©ņØ┤ļź╝ ņżäņØ┤ĻĖ░ ņ£äĒĢ£ 2) ĒĢÖņŖĄĻĖ░ņłĀ(Syn-Real Generalization) ļō▒ Ēü¼Ļ▓ī ļæÉ Ļ░Ćņ¦ĆļĪ£ ļéśļłī ņłś ņ׳ļŗż.

Ļ░ĆņāüļŹ░ņØ┤Ēä░ļ×Ć ņŗżņĀ£ĒÖśĻ▓ĮņŚÉņä£ ņłśņ¦æļÉśĻ▒░ļéś ņĖĪņĀĢļÉśļŖö ļŹ░ņØ┤Ēä░Ļ░Ć ņĢäļŗī ņŗżņĀ£ļŹ░ņØ┤Ēä░ņŚÉ ļīĆĒĢ£ ļīĆņ▓┤ņ×¼ļĪ£ņä£ ļööņ¦ĆĒäĖ ĒÖśĻ▓ĮņŚÉņä£ ņāØņä▒ļÉ£ ņ╗┤Ēō©Ēä░ ņŗ£ļ«¼ļĀłņØ┤ņģśņØ┤ļéś ņĢīĻ│Āļ”¼ņ”śņØ┤ ņāØņä▒ĒĢśļŖö Ļ░ĆņāüņØś ļŹ░ņØ┤Ēä░ņÖĆ ļĀłņØ┤ļĖö ņĀĢļ│┤ļź╝ ļ¦ÉĒĢ£ļŗż. ņØ┤ļ¤¼ĒĢ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļŖö ļŹ░ņØ┤Ēä░Ļ░Ć ĒĢäņÜöĒĢĀ ļĢī ņ¢ĖņĀ£ ņ¢┤ļööņä£ļéś ņ¢┤ļ¢ż ĻĘ£ļ¬©ļĪ£ļÅä ļööņ¦ĆĒäĖ ĒÖśĻ▓ĮņŚÉņä£ ņØĖĻ│ĄņĀüņ£╝ļĪ£ ņāØņä▒ĒĢĀ ņłś ņ׳ļŖö ļŹ░ņØ┤Ēä░ļĪ£ ņל ņäżĻ│äļÉ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś Ļ▓ĮņÜ░ ņłśĒĢÖ ļ░Å ĒåĄĻ│äņĀüņ£╝ļĪ£ ņŗżņĀ£ļŹ░ņØ┤Ēä░ņØś ĒŖ╣ņä▒ņØ┤ ņל ļ░śņśüļÉśņ¢┤ ļöźļ¤¼ļŗØ ļ¬©ļŹĖņØä ĒøłļĀ©ņŗ£ĒéżļŖö ļŹ░ņŚÉ ņŗżņĀ£ļŹ░ņØ┤Ēä░ ļ¬╗ņ¦ĆņĢŖņØĆ ņä▒ļŖźņØä ļ│┤ņØ╝ ņłś ņ׳ļŗżĻ│Ā ņĢīļĀżņĀĖ ņ׳ļŗż[5Ōł╝7].

ļ©ĖņŗĀļ¤¼ļŗØņØä ņ£äĒĢ£ ņ¦ĆļÅäĒĢÖņŖĄ(Supervise Learning)ņÜ® ĒøłļĀ©ļŹ░ņØ┤Ēä░ ņāØņä▒ļČäņĢ╝ļĪ£ ļ▓öņ£äļź╝ ĒĢ£ņĀĢĒĢĀ ļĢī Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ņłĀņØĆ Fig. 2ņŚÉņä£ņÖĆ Ļ░ÖņØ┤ ņ╗┤Ēō©Ēä░ ĻĘĖļלĒöĮ(Computer Graphics, CG)ņØ┤ļéś ņŗ£ļ«¼ļĀłņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢśļŖö 1) ņ╗┤Ēō©Ēä░ ĻĖ░ļ░ś ņāØņä▒ĻĖ░ņłĀĻ│╝ ņāØņä▒ņĀü ņĀüļīĆ ņŗĀĻ▓Įļ¦Ø(Generative Adversarial Networks, GAN)ņØ┤ļéś ļē┤ļ¤┤ ļĀīļŹöļ¦ü(Neural Rendering, NR)Ļ│╝ Ļ░ÖņØĆ 2) ņĢīĻ│Āļ”¼ņ”ś ĻĖ░ļ░ś ņāØņä▒ĻĖ░ņłĀļĪ£ ņäĖļČäĒÖöĒĢĀ ņłś ņ׳ļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ņ╗┤Ēō©Ēä░ ĻĖ░ļ░ś ņāØņä▒ĻĖ░ņłĀ ļ░Å ņĢīĻ│Āļ”¼ņ”ś ĻĖ░ļ░ś ņāØņä▒ĻĖ░ņłĀ ņŚ░ĻĄ¼ļČäņĢ╝ ņżæ ņØ┤ļ»Ėņ¦Ć ņāØņä▒ņĪ░Ļ▒┤ņØś ņĀ£ņ¢┤ņÖĆ ĒÖĢņןņØ┤ ņÜ®ņØ┤ĒĢ£ CG ĻĖ░ļ░śņØś Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ņłĀņØä ļŗżļŻ¼ļŗż.

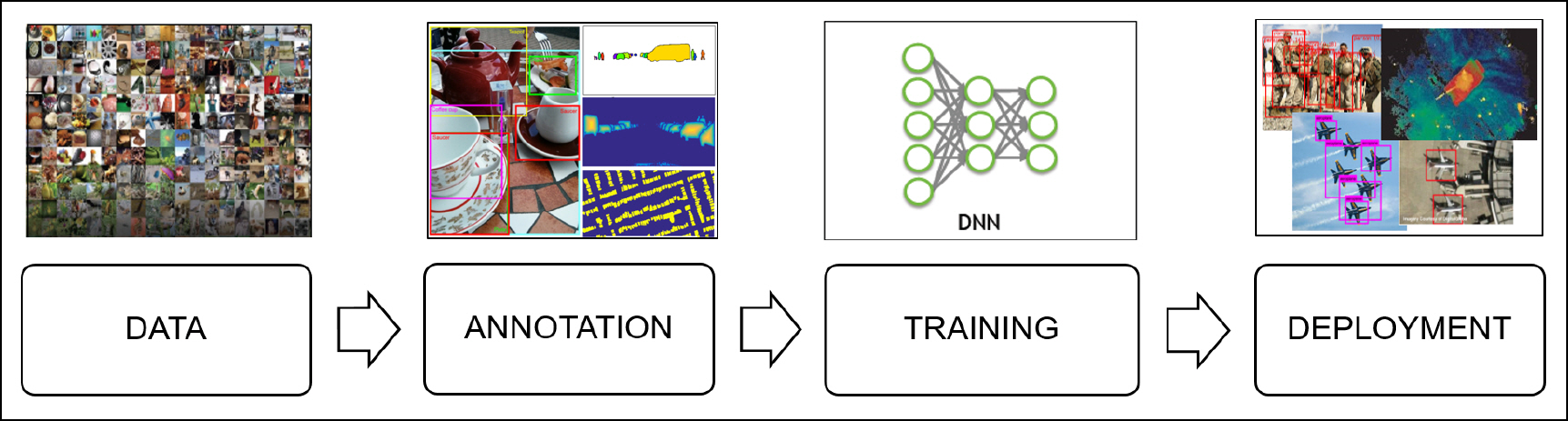

ļöźļ¤¼ļŗØ ĒĢÖņŖĄņÜ®ņ£╝ļĪ£ ļĀłņØ┤ļĖöļ¦üļÉ£ ļŹ░ņØ┤Ēä░ļź╝ ĻĄ¼ņČĢĒĢśļŖö ņØ╝ļ░śņĀüņØĖ ņĀłņ░©ņÖĆ ļ░®ļ▓ĢņØĆ Fig. 3ņŚÉ ļéśĒāĆļéś ņ׳ļŗż. ļöźļ¤¼ļŗØ ĒöäļĪ£ņäĖņŖżņŚÉņä£ļŖö ļöźļ¤¼ļŗØ ĒĢÖņŖĄļ¬®ņĀüņŚÉ ļ¦×ļŖö ĒŖ╣ņä▒Ļ│╝ ļŗżņ¢æņä▒ņØä Ļ░Ćņ¦ä ņŗżņĀ£ ļŹ░ņØ┤Ēä░ļź╝ ņłśņ¦æĒĢśļŖö ļŹ░ņŚÉ ļ¦żņÜ░ ļ¦ÄņØĆ ļ╣äņÜ®Ļ│╝ ņŗ£Ļ░äņØ┤ ņåīņÜöļÉśļ®░ ĒŖ╣Ē׳ Fig. 3ņØś ļĀłņØ┤ļĖöļ¦ü(Annotation) Ļ│╝ņĀĢņŚÉņä£ ļĀłņØ┤ļĖöņØ┤ ņלļ¬╗ ņ¦ĆņĀĢļÉ£ ļŹ░ņØ┤Ēä░ļŖö ņŗ¼ņĖĄņŗĀĻ▓Įļ¦ØņØś ņä▒ļŖźņØä Ēü¼Ļ▓ī ņĀĆĒĢśņŗ£Ēé¼ ņłś ņ׳ĻĖ░ ļĢīļ¼ĖņŚÉ ņĀĢĒÖĢĒĢ£ ļĀłņØ┤ļĖöļĪ£ ņŻ╝ņäØņØä Ēæ£ĻĖ░ĒĢśļŖö Ļ▓āņØ┤ ļ¦żņÜ░ ņżæņÜöĒĢśļŗż. ĒöäļĪ£ĻĘĖļש ļ░®ņŗØņ£╝ļĪ£ ņāØņä▒ļÉśļŖö Ļ░ĆņāüļŹ░ņØ┤Ēä░ļŖö ņłśļÅÖņ£╝ļĪ£ ļŹ░ņØ┤Ēä░ļź╝ ņłśņ¦æĒĢĀ ĒĢäņÜöĻ░Ć ņŚåņ£╝ļ®░ Ļ▒░ņØś ņÖäļ▓ĮĒĢ£ ļĀłņØ┤ļĖöņØä ĒÜŹļōØĒĢĀ ņłś ņ׳ļŗż. ņØĖņ£äņĀüņ£╝ļĪ£ ņāØņä▒ļÉ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļŖö ņ×ÉļÅÖņ£╝ļĪ£ ļĀłņØ┤ļĖöļ¦üņØä ņłśĒ¢ēĒĢśĻ│Ā ļČĆņĪ▒ĒĢ£ ņłśļ¤ēņØä ņ▒äņÜĖ ņłś ņ׳ļŖö ļīĆļ¤ēņØś ļŹ░ņØ┤Ēä░ ņāØņä▒ņØ┤ Ļ░ĆļŖźĒĢśņŚ¼ ņŗ¼ņĖĄņŗĀĻ▓Įļ¦ØņØś ņä▒ļŖźņØä ļåÆņØ╝ ņłś ņ׳ļŗż. ļśÉĒĢ£, ņŗżņĀ£ ļŹ░ņØ┤Ēä░ļź╝ ņłśņ¦æĒĢĀ ļĢī Ļ░£ņØĖ ņĀĢļ│┤ļź╝ ļ│┤ĒśĖĒĢśĻ│Ā ņśżļźśļź╝ ņĀ£Ļ▒░ĒĢśĻ▒░ļéś ļŗżņ¢æĒĢ£ ĒśĢĒā£ņØś ļŹ░ņØ┤Ēä░ļź╝ ļ│ĆĒÖśĒĢśļŖö Ļ▓āņØ┤ ņżæņÜöĒĢ£ Ļ▓ĮņÜ░ņŚÉ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļŖö ņŗżņĀ£ ļŹ░ņØ┤Ēä░ņØś ņżæņÜö ĒŖ╣ņä▒ņØä ļ│┤ņĪ┤ĒĢśļ®┤ņä£ ņŗżņĀ£ ņé¼ļ×īņŚÉ ļīĆĒĢ£ ņĀĢļ│┤ļź╝ ĒżĒĢ©ĒĢśņ¦Ć ņĢŖĻĖ░ ļĢīļ¼ĖņŚÉ Ļ░£ņØĖ ņĀĢļ│┤ ņ╣©ĒĢ┤ņØś ņ£äĒŚśļÅä ņĀ£Ļ▒░ĒĢĀ ņłś ņ׳ļŗż.

ņĄ£ĻĘ╝ Ļ░ĆņāüļŹ░ņØ┤Ēä░ņŚÉ ļīĆĒĢ£ Ļ┤ĆļĀ© ņŚ░ĻĄ¼ņÖĆ ņĀüņÜ®ņé¼ļĪĆĻ░Ć Ēü¼Ļ▓ī ļŖśĻ│Ā ņ׳ņ£╝ļ®░ ĒŖ╣Ē׳ ņśüņāüĻ│╝ ņØ┤ļ»Ėņ¦Ćļź╝ ļŗżļŻ©ļŖö ņ╗┤Ēō©Ēä░ ļ╣äņĀä ļČäņĢ╝ņŚÉņä£ļŖö ļ¢Āņśżļź┤Ļ│Ā ņ׳ļŖö Ļ░Ćņן ņ£Āļ¦ØĒĢ£ ĻĖ░ņłĀ ņżæ ĒĢśļéśļĪ£ Ļ╝ĮĒ׳Ļ│Ā ņ׳ļŗż. Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņŻ╝ņĀ£ļĪ£ ĒĢ£ 1,000ņŚ¼ ĒÄĖņØś ļģ╝ļ¼ĖņØä ņØĖņÜ®ĒĢ£ ņŻ╝ņÜöļ¼ĖĒŚī[1]ņŚÉņä£ļŖö Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ņłĀņØ┤ ļöźļ¤¼ļŗØ ņŚ░ĻĄ¼Ļ░£ļ░£ņŚÉ ļ¦żņÜ░ ĒĢĄņŗ¼ņĀüņØĖ ņŚŁĒĢĀņØä ļŗ┤ļŗ╣ĒĢĀ Ļ▓āņØ┤ļ®░ Ē¢źĒøä ļŹöņÜ▒ ļ¦ÄņØĆ ņĀüņÜ®ņé¼ļĪĆĻ░Ć ļéśņś¼ Ļ▓āņ£╝ļĪ£ ņĀäļ¦ØĒĢśņśĆļŗż. ļśÉĒĢ£ Ļ░ĆĒŖĖļäł(Gartner)ļŖö 2030ļģäņŚÉ ņØ┤ļź┤ļ®┤ ņØĖĻ│Ąņ¦ĆļŖźĻ░£ļ░£ņŚÉ ņé¼ņÜ®ļÉśļŖö ļŹ░ņØ┤Ēä░ ļīĆļČĆļČäņØ┤ ĻĘ£ņ╣Ö, ĒåĄĻ│äļ¬©ļŹĖ, ņŗ£ļ«¼ļĀłņØ┤ņģś ļō▒ņŚÉ ņØśĒĢ£ ņØĖĻ│ĄņĀüņ£╝ļĪ£ ņāØņä▒ļÉ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØ╝ Ļ▓āņ£╝ļĪ£ ļ│┤Ļ│Ā Ē¢źĒøä Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢ┤ Ļ│ĀĒÆłņ¦łņØś ņØĖĻ│Ąņ¦ĆļŖźļ¬©ļŹĖņØä ļ¦īļōż ņłś ņ׳ņØä Ļ▓āņØ┤ļØ╝Ļ│Ā ņśłņĖĪĒĢśņśĆļŗż[11,12].

Ļ░ĆņāüļŹ░ņØ┤Ēä░ ļŗ©ņØ╝ ņØ┤ļ»Ėņ¦Ćļź╝ ņØĖĻ│ĄņĀüņ£╝ļĪ£ ņāØņä▒ĒĢĀ ļĢī ļĀłņØ┤ļĖöļ¦ü ļŗ©Ļ│äņŚÉņä£ņØś ļ╣äņÜ®ņØ┤ ņŗżļ¼╝ ņØ┤ļ»Ėņ¦ĆņŚÉ ļ╣äĒĢ┤ ņĢĮ 1/100 Ļ░Ćļ¤ē ņĀłĻ░ÉļÉśļŖö Ļ▓āņ£╝ļĪ£ ņČöņĀĢ[1,2]ļÉ£ļŗż. Ļ░ĆņāüļŹ░ņØ┤Ēä░ļŖö Ļ░ĆļĀżņ¦É, ĻĖ░Ēøä, ĒÖöņ×¼, ņé¼Ļ│Ā ļō▒ņØś ĒŖ╣ņłśĒĢ£ Ļ▓ĮņÜ░ļź╝ ņØśļÅäņĀüņ£╝ļĪ£ ĒĢÖņŖĄļŹ░ņØ┤Ēä░ņŚÉ ĒżĒĢ©ņŗ£Ēé¼ ņłś ņ׳Ļ│Ā ĒśäņŗżņäĖĻ│äļź╝ ļīĆļ│ĆĒĢśĻĖ░ ņ£äĒĢ£ ļŹ░ņØ┤Ēä░ ļŗżņ¢æņä▒ ĒÖĢļ│┤ ņĖĪļ®┤ņŚÉņä£ ļŹ░ņØ┤Ēä░ņØś ĒÄĖĒ¢ź(bias)ļź╝ ņżäņØ┤Ļ│Ā ņŗżņĀ£ļŹ░ņØ┤Ēä░ņØś ļČłņČ®ļČäĒĢ£ ļČäĒżļź╝ ļ│┤ņÖäĒĢśļŖö ņżæņÜöĒĢ£ ņłśļŗ©ņØ┤ ļÉĀ ņłś ņ׳ļŗż. ļśÉĒĢ£ ĒśäņŗżņäĖĻ│äņŚÉņä£ļŖö ĒÜŹļōØĒĢśĻĖ░ ņ¢┤ļĀĄĻ▒░ļéś ļČłĻ░ĆļŖźĒĢ£ ņśüņāüņØś Ļ╣ŖņØ┤ņĀĢļ│┤, ņŖżĒģīļĀłņśż ņØ┤ļ»Ėņ¦Ć ņĀĢĒĢ®, 3ņ░©ņøÉ Ļ│ĄĻ░ä ļĀłņØ┤ļĖö ņĀĢļ│┤ ļō▒ņØś ļĀłņØ┤ļĖöļ¦üņØ┤ Ļ░ĆļŖźĒĢ£ ņןņĀÉļÅä Ļ░¢Ļ│Ā ņ׳ņ£╝ļ®░ ņØ┤ļ»Ėņ¦ĆļäĘņØ┤ļéś ņśżĒöłņØ┤ļ»Ėņ¦ĆņÖĆ Ļ░ÖņØĆ Ļ│ĄĻ░£ļÉ£ ļŹ░ņØ┤Ēä░Ļ░Ć ņ¦ĆņøÉĒĢśņ¦Ć ļ¬╗ĒĢśļŖö ĒŖ╣ņä▒ņØ┤ ļŗżļźĖ ļÅäļ®öņØĖĻ│╝ ņ╣┤ļ®öļØ╝ ņäĖĒīģņØś ļ│ĆļÅÖ ļ░Å ĒŖ╣ņØ┤ĒśĢņāü ļō▒ņŚÉ ļīĆĒĢ┤ņä£ļŖö Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś ĒÖ£ņÜ®ņä▒Ļ│╝ ņ£ĀĒÜ©ņä▒ņØ┤ ļŹöņÜ▒ļŹö ļåÆņĢäņ¦ł ņłś ņ׳ļŗż.

ļöźļ¤¼ļŗØ ĒĢÖņŖĄņÜ®ņ£╝ļĪ£ ļĀłņØ┤ļĖöļ¦üļÉ£ ļŹ░ņØ┤Ēä░ļź╝ ĻĄ¼ņČĢĒĢśļŖö ņØ╝ļ░śņĀüņØĖ ņĀłņ░©ļź╝ ĻĖ░ņżĆņ£╝ļĪ£ ņ×Éņ£©ņŻ╝Ē¢ē ņ░©ļ¤ēņØä ņśłļĪ£ ļōżĻ▓ī ļÉśļ®┤ ņ▓½ ļ▓łņ¦Ė ļŹ░ņØ┤Ēä░ ņłśņ¦æļŗ©Ļ│äņŚÉņä£ļŖö ņ×ÉļŻīņłśņ¦æņä╝ņä£Ļ░Ć ņןņ░®ļÉ£ ņ×Éņ£©ņŻ╝Ē¢ēņ░©ļ¤ēņØä ņÜ┤Ē¢ēĒĢśĻ│Ā ņŚ¼ĻĖ░ņä£ ņ¢╗ņ¢┤ņ¦ĆļŖö ļŹ░ņØ┤Ēä░ņŚÉ ļīĆĒĢ£ ņłśņ¦æĻ│╝ ņĀĆņןņØ┤ ņØ┤ļŻ©ņ¢┤ņ¦äļŗż. ļæÉ ļ▓łņ¦Ė ļŹ░ņØ┤Ēä░ ļĀłņØ┤ļĖöļ¦ü ļŗ©Ļ│äņŚÉņä£ļŖö ņłśņ¦æļÉ£ ļ¦ÄņØĆ ļŹ░ņØ┤Ēä░ņŚÉņä£ ņĢīĻ│Āļ”¼ņ”ś Ļ░£ļ░£ņŚÉ ĒĢäņÜöĒĢ£ ļŹ░ņØ┤Ēä░ņŚÉ ļīĆĒĢ£ Ļ▓ĆĒåĀņÖĆ ņäĀĒāØņØ┤ ņØ┤ļŻ©ņ¢┤ņ¦ĆĻ│Ā Ļ┤Ćņŗ¼ņ׳ļŖö ļŹ░ņØ┤Ēä░ņŚÉ ļīĆĒĢ£ ļĀłņØ┤ļĖöļ¦üņØä ņłśĒ¢ēĒĢśĻ▓ī ļÉ£ļŗż. ļ¦łņ¦Ćļ¦ē ļŗ©Ļ│äņŚÉņä£ļŖö ļĀłņØ┤ļĖöļ¦üļÉ£ ļŹ░ņØ┤Ēä░ļĪ£ ļöźļ¤¼ļŗØ ņĢīĻ│Āļ”¼ņ”śņØä ĒøłļĀ©ņŗ£ĒéżĻ│Ā ĒĢÖņŖĄļÉ£ ļ¬©ļŹĖņØä ĒÖ£ņÜ®ĒĢśļŖö ļŗ©Ļ│äļĪ£ ņØ┤ļŻ©ņ¢┤ņ¦äļŗż. ĒśäņŗżņŚÉņä£ļŖö ņŗżņĀ£ļŹ░ņØ┤Ēä░ļź╝ ļīĆņ▓┤ĒĢĀ ņłś ņ׳ļŖö ņłśņżĆņØś Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ļ¦īļō£ļŖö Ļ▓āņØ┤ ļČłĻ░ĆļŖźĒĢśļ»ĆļĪ£, ļīĆņŗĀ ņ╗┤Ēō©Ēä░ ļ╣äņĀäņØä ņ£äĒĢ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ 3ņ░©ņøÉ Ļ░ĆņāüĻ│ĄĻ░äņØś ĻĄ¼ņä▒ĒĢśĻ▒░ļéś ļĀīļŹöļ¦üļÉ£ 2ņ░©ņøÉ ņØ┤ļ»Ėņ¦Ć ņłśņżĆņŚÉņä£ ņłśļ¦ÄņØĆ ļ│ĆĒśĢņØä ĒåĄĒĢ┤ ļ¼┤ņ×æņ£äĒÖöĒĢśņŚ¼ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ļŹ░ņØ┤Ēä░ ļČäĒżĻ░Ć ņČ®ļČäĒ׳ ĒÅŁļäōĻ│Ā ļŗżņ¢æĒĢśĻ▓ī ļ¦īļō£ļŖö ļÅäļ®öņØĖ ļ×£ļŹżĒÖö(Domain Randomization, DR)ļź╝ ņŻ╝ļĪ£ ņé¼ņÜ®ĒĢ£ļŗż. ņØ┤ļ¤¼ĒĢ£ ļÅäļ®öņØĖ ļ×£ļŹżĒÖö ļ░®ļ▓Ģ[14Ōł╝16]ņØĆ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ņŗ£ņŚÉ ņĀäņØ┤ĒĢÖņŖĄ(Transfer Learning) ĒÜ©Ļ│╝ļź╝ ļåÆņØ┤ĻĖ░ ņ£äĒĢ┤ Ļ░Ćņāü-ņŗżņĀ£ ļŹ░ņØ┤Ēä░ Ļ░äņØś Ļ░äĻĘ╣ņØä ņżäņØ┤Ļ│Ā ļŹ░ņØ┤Ēä░ņØś ļČäĒż ļŗżņ¢æĒÖöļź╝ ņØ┤ļŻ©ļŖö Ļ░Ćņן ņ£ĀņÜ®ĒĢ£ ļ░®ņĢłņ£╝ļĪ£ Ļ╝ĮĒ׳Ļ│Ā ņ׳ļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ņé¼ņÜ®ĒĢ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░(Fig. 4)ļŖö ļīĆņāüļ¼╝ņ▓┤ņŚÉ ļīĆĒĢ£ 3ņ░©ņøÉ CAD ļ¬©ļŹĖļ¦üĻ│╝ CG ļĀīļŹöļ¦ü Ļ│╝ņĀĢņØä ĒåĄĒĢ┤ ņāØņä▒ĒĢśņśĆņ£╝ļ®░ ļÅäļ®öņØĖ ļ×£ļŹżĒÖöļź╝ ņ£äĒĢ┤ Ļ░Øņ▓┤ĒāÉņ¦Ć ļīĆņāü Ļ░Øņ▓┤ņØś ņłśļ¤ē, Ļ░Øņ▓┤ņØś ņ£äņ╣ś, ĒāÉņ¦Ćļ░®ĒĢ┤ļ¼╝ņ▓┤(Distracter)ņØś ņłśļ¤ēĻ│╝ ĒśĢĒā£, ņןļ®┤ĻĄ¼ņä▒ņÜ® ļ░░Ļ▓Į ļ░Å Ļ░Øņ▓┤ņØś Ēæ£ļ®┤ņ¦łĻ░É ļō▒ņØä ļ¼┤ņ×æņ£äĒĢśĻ▓ī ņØ┤ļ»Ėņ¦Ć ļŹ░ņØ┤Ēä░ļź╝ ņāØņä▒ĒĢśļÅäļĪØ ĒĢśņśĆļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ ņāØņä▒ļÉ£ ņØ┤ļ»Ėņ¦ĆļōżņØĆ Fig. 5ņŚÉņä£ņÖĆ Ļ░ÖņØ┤ ņāüļŗ╣ļČĆļČä ļ╣äĒśäņŗżņĀüņØ┤ĻĖ░ļŖö ĒĢśņ¦Ćļ¦ī Ļ░Øņ▓┤ĒāÉņ¦Ćļ¬©ļŹĖņØ┤ ĒĢÖņŖĄĻ│╝ņĀĢņŚÉņä£ ļŗżļźĖ ņÜöņåīļōżņŚÉ ņāüĻ┤ĆņŚåņØ┤ Ļ░Øņ▓┤ņØś ĒśĢĒā£ņŚÉļ¦ī ņ¦æņżæĒĢĀ ņłś ņ׳ļÅäļĪØ ĻĘĖļלĒöĮ ļĀīļŹöļ¦ü Ļ│╝ņĀĢņØä ĒåĄĒĢ┤ ņāØņä▒ĒĢśņśĆļŗż. Ļ░Øņ▓┤ĒāÉņ¦Ć ņŚ░ĻĄ¼ļź╝ ņ£äĒĢ┤ Ļ│ĀņĢłļÉ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ļŖö ņŗżņĀ£ņāüĒÖ®ņØä ņל ļ░śņśüĒĢśĻ│Ā ņāØņä▒ļÉ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ļ¦īņ£╝ļĪ£ļÅä ņŗżņĀ£ ļŹ░ņØ┤Ēä░ļź╝ ļ╣äĻĄÉņĀü ņĀĢĒÖĢĒĢśĻ▓ī ņśłņĖĪĒĢĀ ņłś ņ׳ļÅäļĪØ CAD(Blender) ņ×æņŚģĻ│╝ Ļ▓īņ×äņŚöņ¦ä(Unity 3D)ņØś ļØ╝ņØ┤ļĖīļ¤¼ļ”¼ ĻĖ░ļŖźļōżņØä ņØ┤ņÜ®ĒĢśņŚ¼ ņĀ£ņ×æĒĢśņśĆļŗż. ļśÉĒĢ£ Fig. 6ņŚÉņä£ņÖĆ Ļ░ÖņØ┤ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ļŖö ņāØņä▒ļÉ£ ņןļ®┤(Scene)ņŚÉņä£ņØś ļ¼╝ņ▓┤ņØś Ļ╣ŖņØ┤, ļ░śņé¼, Ļ▒░ņ╣ĀĻĖ░ņÖĆ Ļ░ÖņØĆ ļČĆĻ░ĆņĀüņØĖ ņĀĢļ│┤ļÅä ĒĢ©Ļ╗ś ņĀ£Ļ│ĄĒĢĀ ņłś ņ׳ļÅäļĪØ ĒĢśņśĆļŗż.

Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś ļöźļ¤¼ļŗØ ņĀüņÜ®ņŚ░ĻĄ¼ļŖö ņ┤łĻĖ░ņŚÉ ĒśĢĒā£ļ¦ī ņĢīņĢäļ│╝ ņłś ņ׳ļŖö ņĀĆņłśņżĆņØś Ļ░ĆņāüļŹ░ņØ┤Ēä░Ļ░Ć ņé¼ņÜ®ļÉśņŚłņ£╝ļ®░ ņØ┤Ēøä ņĀĆņłśņżĆņØś Ļ░ĆņāüļŹ░ņØ┤Ēä░ņÖĆ Ļ│ĀņłśņżĆņØś ņŗżņĀ£ ņØ┤ļ»Ėņ¦Ć ņ░©ņØ┤ņŚÉņä£ ļ░£ņāØĒĢśļŖö ļöźļ¤¼ļŗØ ĒĢÖņŖĄņä▒ļŖź ņĀĆĒĢśļź╝ ļ¦ēĻĖ░ ņ£äĒĢ£ ļ░®ņĢłņØś ĒĢśļéśļĪ£ ņāłļĪ£ņÜ┤ Ēü┤ļלņŖżņŚÉ ļīĆĒĢ£ ņĀäņØ┤ĒĢÖņŖĄ ņłśĒ¢ē ņŗ£ ņŗ¼ņĖĄņŗĀĻ▓Įļ¦Ø ņĢ×ņ¬Į ĒĢśņĖĄļČĆļŖö ņŗżņĀ£ ņØ┤ļ»Ėņ¦ĆņŚÉ ļīĆĒĢ£ ĻĖ░ļ│ĖņĀüņØĖ ĒŖ╣ņä▒ņČöņČ£ ĻĖ░ļŖźņØ┤ ļé©ņĢäņ׳ļÅäļĪØ Ļ│ĀņĀĢĒĢśĻ│Ā Ļ░Øņ▓┤ ļČäļźśĻĖ░(Classifier)Ļ░Ć ņ׳ļŖö ļ¦łņ¦Ćļ¦ē ņĄ£ņāüņĖĄļČĆļŖö ļ»ĖņäĖņĪ░ņĀĢ(Fine-Tuning)ĒĢśļÅäļĪØ ĒĢśļŖö ļ░®ļ▓ĢļĪĀņØ┤ Ļ░£ļ░£ļÉśņŚłļŗż. ņØ┤ļ¤¼ĒĢ£ ņĀäņØ┤ĒĢÖņŖĄ ļ░®ļ▓ĢņØĆ ņĀÉņ░© ļ░£ņĀäĒĢśņŚ¼ ņŗ¼ņĖĄņŗĀĻ▓Įļ¦Ø Ļ░ü ļĀłņØ┤ņ¢┤ļ│äļĪ£ ļ¦×ņČżĒśĢ ĒĢÖņŖĄņØä ņłśĒ¢ēĒĢśĻ▒░ļéś ĒĢśļŖö ļō▒ņØś ļÅäļ®öņØĖ ņØ╝ļ░śĒÖö(Domain Generalization) ļ░®ļ▓ĢļĪĀņ£╝ļĪ£ ļ░£ņĀäĒĢ┤ņÖöļŗż. ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ņĀäņØ┤ĒĢÖņŖĄ ņłśĒ¢ēņŗ£ ņé¼ņĀäĒĢÖņŖĄļÉ£ ļ¬©ļŹĖņŚÉņä£ ĒĢÖņŖĄļīĆņāüņØĖ ņŗ¼ņĖĄņŗĀĻ▓Įļ¦ØņØś ĒŖ╣ņ¦ĢņČöņČ£ ņ┤łĻĖ░ ļĀłņØ┤ņ¢┤ļź╝ Ļ│ĀņĀĢĒĢśņŚ¼ ĻĖ░ņĪ┤ ĒĢÖņŖĄļÉ£ ĻĖ░ļŖźņØä ļ│┤ņĪ┤ĒĢśĻ│Ā, ņØ┤Ēøä ļĀłņØ┤ņ¢┤ļōżļ¦īņØä ļ»ĖņäĖņĪ░ņĀĢĒĢśņŚ¼ Ļ░Øņ▓┤ĒāÉņ¦ĆņŚÉ ļ¦×ļŖö ņāłļĪ£ņÜ┤ ĻĖ░ļŖźņØä ĒĢÖņŖĄĒĢĀ ņłś ņ׳ļÅäļĪØ ĒĢśņśĆļŗż.

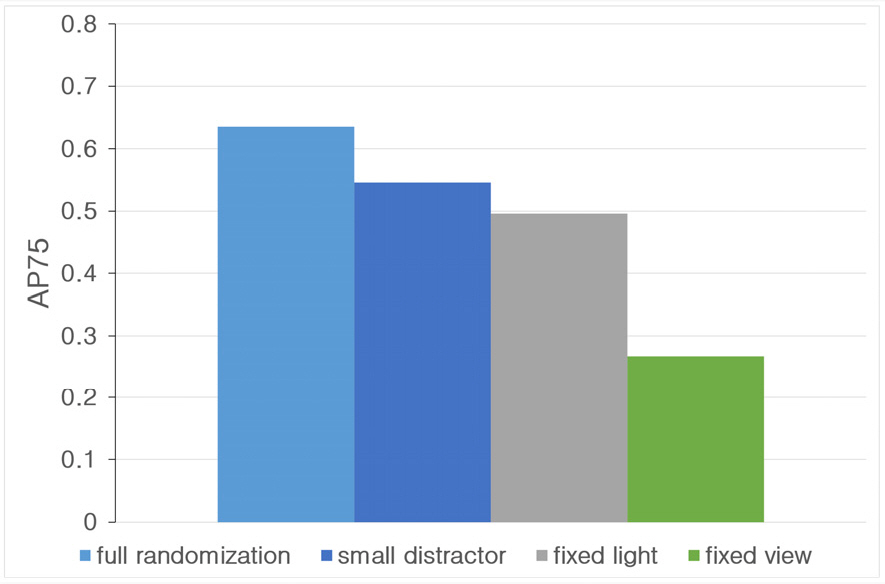

Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ĒÜ©ņ£©ņĀüņ£╝ļĪ£ ņāØņä▒ĒĢśĻĖ░ ņ£äĒĢ┤ ļÅäļ®öņØĖ ļČäĒż ļŗżņ¢æĒÖö(DR) ļ░®ļ▓ĢĻ│╝ ĒśäņŗżĻ░É ņ׳ļŖö ļŹ░ņØ┤Ēä░ļź╝ ļ¦īļōżĻĖ░ ņ£äĒĢ┤ Ļ│Āņä▒ļŖź ĻĘĖļלĒöĮ ļĀīļŹöļ¦ü ĻĖ░ņłĀņØä ņé¼ņÜ®ĒĢśļŖö ļ░®ļ▓Ģ ļ░Å ņŗżņĀ£ ņØ┤ļ»Ėņ¦Ć ļŹ░ņØ┤Ēä░ņÖĆ 3ņ░©ņøÉ ĒśĢņāü Ļ░Øņ▓┤ ļŹ░ņØ┤Ēä░ļź╝ ņĪ░ĒĢ®ĒĢśņŚ¼ ņāłļĪ£ņÜ┤ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ļ¦īļō£ļŖö ļ░®ļ▓Ģ[17Ōł╝23]ļōżņØä ĒĢ©Ļ╗ś ņĀüņÜ®ĒĢśņśĆļŗż. ļÅäļ®öņØĖ ļ×£ļŹżĒÖöņŚÉ ļīĆĒĢ£ ĒīīļØ╝ļ»ĖĒä░ ĒÜ©Ļ│╝ļÅä ĒÅēĻ░Ćļź╝ ņ£äĒĢ┤ Ļ┤æņøÉņäĖĻĖ░ ļ¼┤ņ×æņ£äĒÖö, ĒāÉņ¦Ćļ░®ĒĢ┤ļ¼╝ ņČöĻ░Ć ļ░Å ņ╣┤ļ®öļØ╝ ņ£äņ╣ś ļ¼┤ņ×æņ£ä ļ░░ņ╣ś ļō▒ņØś ĻĖ░ļŖźņØä ĒĢśļéśņö® ņĀ£ņÖĖĒĢśļ®┤ņä£ ņŗżĒŚśņØä ņłśĒ¢ēĒĢśņśĆĻ│Ā Fig. 7ņŚÉņä£ņÖĆ Ļ░ÖņØ┤ ņŗ£ņĢ╝Ļ░ü, ņØĖĻ│Ą ļ░®ĒĢ┤ļ¼╝, Ļ┤æņøÉ ņĪ░ņĀł ļō▒ņØś ĒÜ©Ļ│╝ļź╝ ĒÖĢņØĖĒĢĀ ņłś ņ׳ņŚłļŗż.

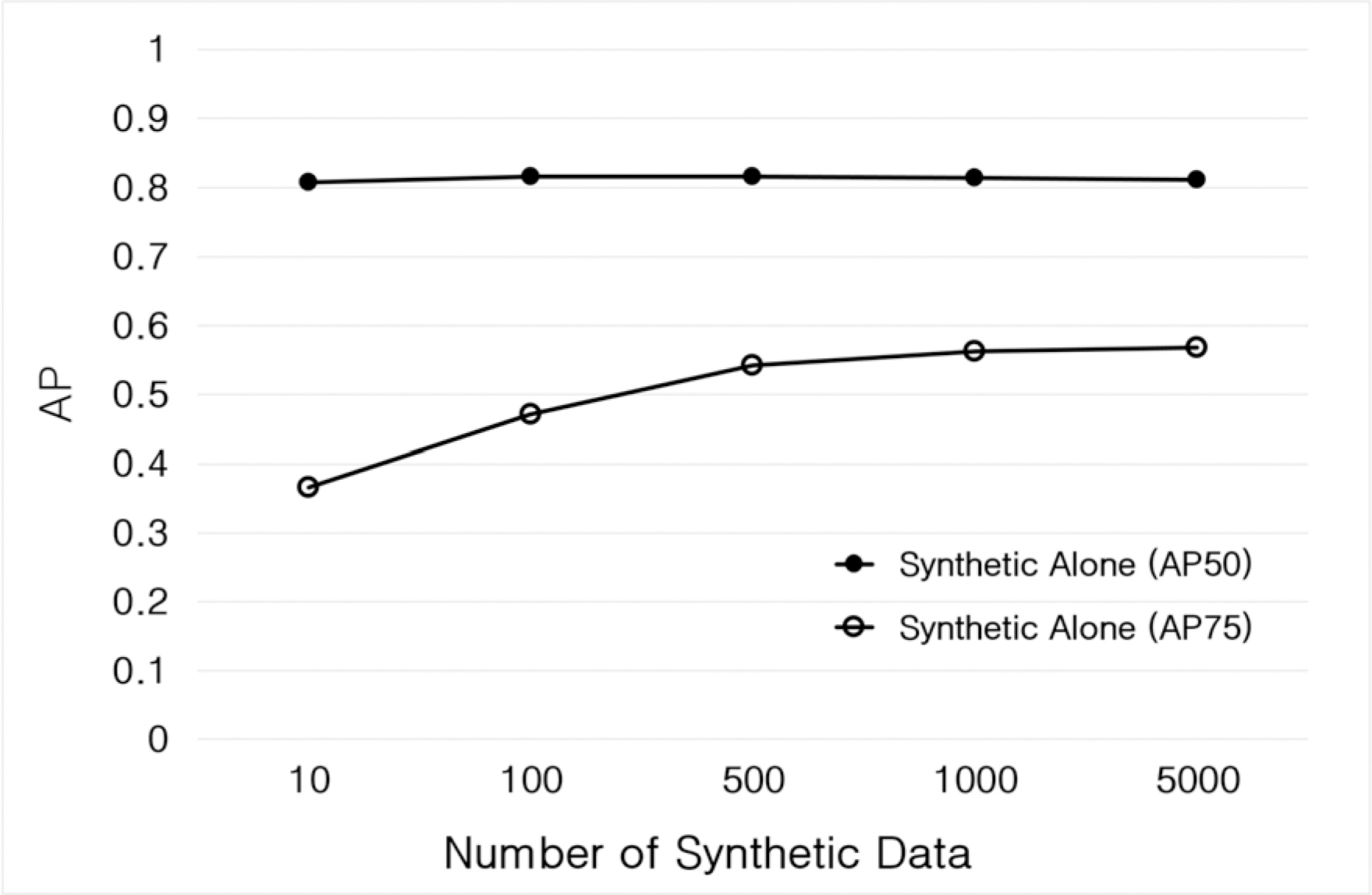

ļöźļ¤¼ļŗØ ĒĢÖņŖĄĻ│╝ņĀĢņŚÉļŖö MS-COCO Pre-Trained Faster R-CNN(Inception Resnet V2) ļ¬©ļŹĖĻ│╝ ĻĄ░ņÜ®ļ¼╝ņ▓┤ņÜ® ņāØņä▒ĻĖ░ņŚÉņä£ ļ¦īļōżņ¢┤ņ¦ä Ļ░Øņ▓┤ĒāÉņ¦ĆņÜ® Ļ░ĆņāüļŹ░ņØ┤Ēä░Ļ░Ć ņé¼ņÜ®ļÉśņŚłņ£╝ļ®░, ņä▒ļŖźĒÅēĻ░ĆņŚÉļŖö ņØĖĒä░ļäĘņŚÉņä£ ņłśņ¦æļÉ£ ņŗżņĀ£ ĻĄ░ņÜ®ļ¼╝ņ▓┤ 1,000ņןņØś ļĀłņØ┤ļĖöļÉ£ ņØ┤ļ»Ėņ¦Ć ļŹ░ņØ┤Ēä░Ļ░Ć ņé¼ņÜ®ļÉśņŚłļŗż. Fig. 8ņØĆ ļöźļ¤¼ļŗØ ĒĢÖņŖĄņÜ® Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņłśļ¤ē ņ”ØĻ░ĆņŚÉ ļö░ļźĖ ņä▒ļŖźĒÅēĻ░ĆĻ▓░Ļ│╝ņØ┤ļŗż. ņŗżĒŚśĻ▓░Ļ│╝ļĪ£ļČĆĒä░ AP50ņŚÉņä£ļŖö Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś ņłśļ¤ē ņ”ØĻ░Ć(5,000ņן)ņŚÉ ļö░ļźĖ ņä▒ļŖźļ│ĆĒÖöĻ░Ć ņ×æņØĆ ĻĘĀņØ╝ĒĢ£ ņä▒ļŖźņØä ļ│┤ņśĆņ£╝ļéś AP75ņØś Ļ▓ĮņÜ░ Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś ņłśļ¤ē ņ”ØĻ░ĆņŚÉ ļö░ļØ╝ Ēü░ ĒÅŁņØś ņä▒ļŖźĒ¢źņāü ņĖĪņĀĢĻ▓░Ļ│╝Ļ░Ć Ļ┤ĆņĖĪļÉśņŚłļŗż. ņØ┤ņŚÉ ļö░ļØ╝ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢ£ ļöźļ¤¼ļŗØ ĒĢÖņŖĄņØĆ 1,000ņןņØś Ļ░ĆņāüļŹ░ņØ┤Ēä░ļ¦īņØä ņé¼ņÜ®ĒĢśņŚ¼ ņĀäņØ┤ĒĢÖņŖĄ ĻĖ░ļ░ś ļ»ĖņäĖņĪ░ņĀĢņØä ņłśĒ¢ēĒĢśņśĆņ£╝ļ®░ ĒĢÖņŖĄņ┤łĻĖ░ļČĆĒä░ ņŗżņĀ£ļŹ░ņØ┤Ēä░ņÖĆ Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ Ēś╝ĒĢ®ĒĢ£ ĒĢśņØ┤ļĖīļ”¼ļō£ ļŹ░ņØ┤Ēä░ņģŗ ĻĖ░ļ░ś ĒĢÖņŖĄņØä ņłśĒ¢ēĒĢśļŖö ĒĢ®ļÅÖĒĢÖņŖĄ(Joint Training)ļÅä ĒĢ©Ļ╗ś ņłśĒ¢ēĒĢśņśĆļŗż.

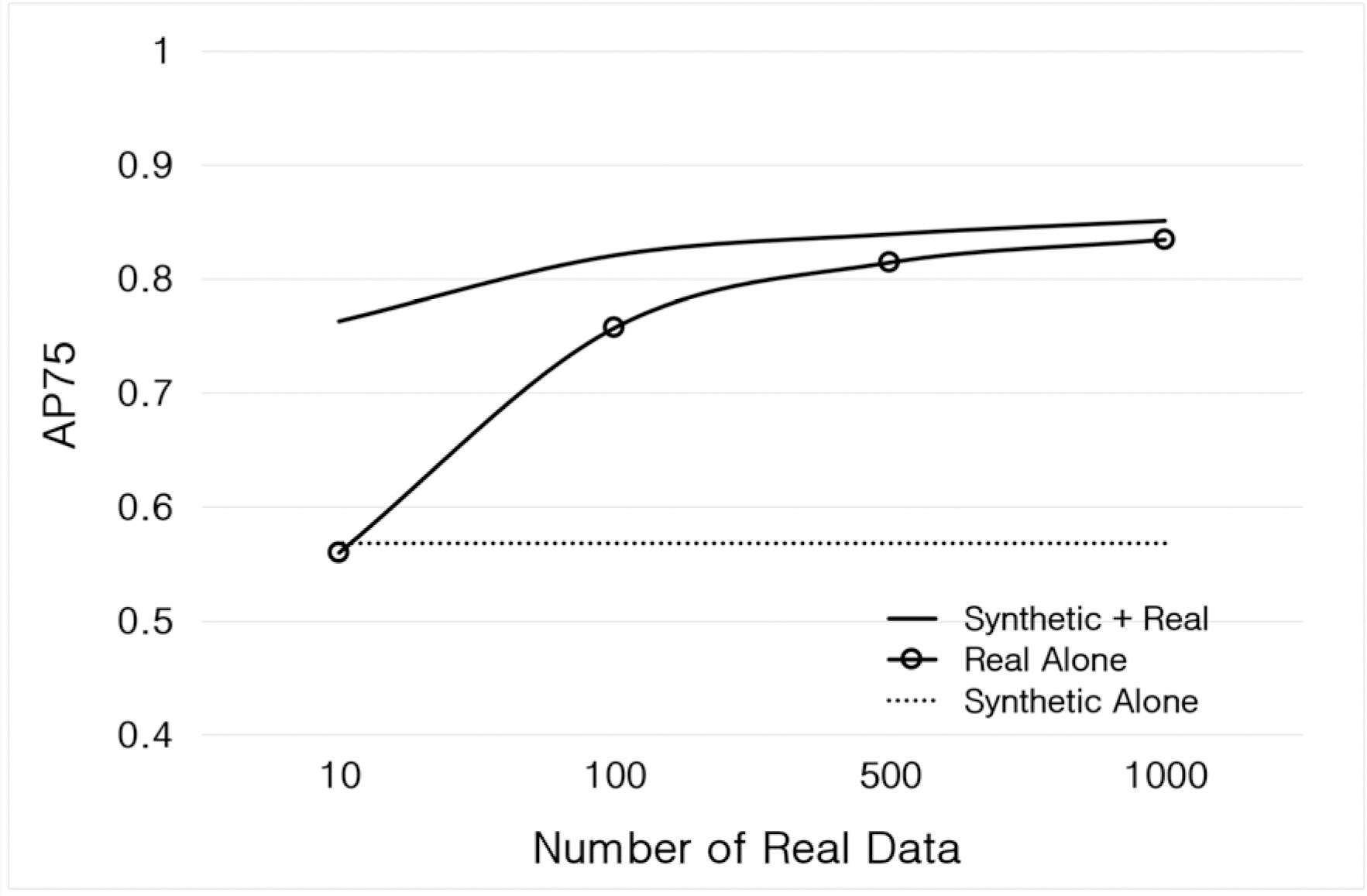

ĻĄ░ņÜ®ļ¼╝ņ▓┤ ĒāÉņ¦ĆņŚ░ĻĄ¼ļź╝ ņ£äĒĢ£ ĒĢÖņŖĄņÜ® Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢ£ ĒāÉņ¦Ćļ¬©ļŹĖ ņČöļĪĀĻ▓░Ļ│╝ļŖö Fig. 9ņÖĆ Fig. 10ņŚÉ ļéśĒāĆļéś ņ׳ņ£╝ļ®░ ņŗżĒŚśĻ▓░Ļ│╝ļĪ£ļČĆĒä░ Ļ░ĆņāüļŹ░ņØ┤Ēä░(Synthetic Alone), ņŗżņĀ£ļŹ░ņØ┤Ēä░(Real Alone) ļ░Å ĒĢśņØ┤ļĖīļ”¼ļō£ ļŹ░ņØ┤Ēä░(Synthetic + Real) Ļ░üĻ░üņŚÉ ļīĆĒĢ£ ĒĢÖņŖĄņä▒ļŖź Ē¢źņāüĒÜ©Ļ│╝ļź╝ ĒÖĢņØĖĒĢĀ ņłś ņ׳ņŚłļŗż. Ļ░Øņ▓┤ĒāÉņ¦Ć ļ¬©ļŹĖ ņČöļĪĀĻ▓░Ļ│╝ņØĖ Fig. 11ņØś Ļ▓░Ļ│╝ļĪ£ļČĆĒä░ ņŗżņĀ£ ļŹ░ņØ┤Ēä░ļź╝ ņĀäĒśĆ ņé¼ņÜ®ĒĢśņ¦Ć ņĢŖņØĆ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ļ¦īņ£╝ļĪ£ ņĀäņØ┤ĒĢÖņŖĄņØä ņłśĒ¢ēĒĢ£ ļöźļ¤¼ļŗØ ļ¬©ļŹĖ(Synthetic Alone)ņØ┤ ņŗżņĀ£ ĻĄ░ņÜ®ļ¼╝ņ▓┤ļź╝ ņל ĒāÉņ¦ĆĒĢśĻ│Ā ņ׳ņØīņØä ņĢī ņłś ņ׳ļŗż. ĻĄ░ņÜ®ļ¼╝ņ▓┤ĒāÉņ¦ĆņÜ® Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢśņŚ¼ ļöźļ¤¼ļŗØ ļ¬©ļŹĖņØä ĒĢÖņŖĄņŗ£ņ╝░ņØä Ļ▓ĮņÜ░ ļŗ©ņØ╝ļ¼╝ņ▓┤ ĻĖ░ļ░ś ļ¼╝ņ▓┤ĒāÉņ¦Ć ņĀĢĒÖĢļÅä 85 %(AP50)ņÖĆ 64 %(AP75)ļź╝ ņ¢╗ņØä ņłś ņ׳ņŚłļŗż[15].

ņ░©ļ¤ēĻ│╝ Ļ░ÖņØĆ 3ņ░©ņøÉ ĒśĢņāüņØś Ļ░Øņ▓┤ĒāÉņ¦Ć ļöźļ¤¼ļŗØ ļ¬©ļŹĖņØä Ļ│ĄĻ▓®ĒĢśļŖö ļ¼╝ļ”¼ņĀü Ļ│ĄĻ▓®(Physical Adversarial Attacks)ņØä ņ£äĒĢ┤ņä£ļŖö 2ņ░©ņøÉ Ēī©ņ╣śļź╝ ļČĆņ░®ĒĢśļŖö ļ░®ļ▓ĢņŚÉ ļ╣äĒĢ┤ 3ņ░©ņøÉ ĒģŹņŖżņ▓ś ĻĖ░ļ░ś ļ¼╝ļ”¼Ļ│ĄĻ▓® ļ░®ļ▓ĢņØś Ļ│ĄĻ▓®ņä▒ļŖźņØ┤ ļŹö ļåÆņØĆ Ļ▓āņ£╝ļĪ£ ņĢīļĀżņĀĖ ņ׳ņ£╝ļ®░, ņØ┤ļ¤¼ĒĢ£ ĒģŹņŖżņ▓ś ņĪ░ņ×æ Ļ│ĄĻ▓®ļ¬©ļŹĖņØś Ļ░£ļ░£ņØä ņ£äĒĢ£ ņ╗┤Ēō©Ēä░ ĻĘĖļלĒöĮ ņŗ£ļ«¼ļĀłņØ┤ņģś Ļ┤ĆļĀ© ņŚ░ĻĄ¼[24Ōł╝26]ļÅä ņĄ£ĻĘ╝ ĒÖ£ļ░£Ē׳ ņ¦äĒ¢ēļÉśĻ│Ā ņ׳ļŗż. Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ĒÖ£ņÜ®ĒĢśņŚ¼ ļŗżņ¢æĒĢ£ ņāüĒÖ®Ļ│╝ ņĪ░Ļ▒┤ņŚÉ ļīĆĒĢ£ ņĀüļīĆņĀü Ļ│ĄĻ▓®ņłśĒ¢ēņØ┤ Ļ░ĆļŖźĒĢśļÅäļĪØ ĒĢśĻĖ░ ņ£äĒĢ┤ņä£ļŖö ņŗżņĀ£ĒÖśĻ▓ĮĻ│╝ ņ£Āņé¼ĒĢ£ ĻĘĖļלĒöĮ ņŚöņ¦ä ĻĖ░ļ░ś Ļ░Ćņāü ņŗ£ļ«¼ļĀłņØ┤ņģś ĒÖśĻ▓ĮņØś ĻĄ¼ņä▒Ļ│╝ ļ¼╝ļ”¼ņĀü Ļ│ĄĻ▓®ĻĖ░ņłĀ Ļ░£ļ░£ņØä ņ£äĒĢ£ ļŗżņ¢æĒĢ£ Ļ░Øņ▓┤ņØś ņĪ░ņ×æĻĖ░ļŖź(ĒģŹņŖżņ▓ś ļ│ĆĻ▓Į, Ēī©ņ╣ś ļČĆņ░® ļō▒)ņØś ĻĄ¼ĒśäņØ┤ Ļ░ĆļŖźĒĢ┤ņĢ╝ĒĢ£ļŗż.

ļ│Ė ņŚ░ĻĄ¼ņŚÉņä£ļŖö ņŗżņĀ£ĒÖśĻ▓ĮņŚÉņä£ ĻĄ¼ĒśäĒĢśĻĖ░ ņ¢┤ļĀżņÜ┤ ņŚ¼ļ¤¼ Ļ░Ćņ¦Ć ņĪ░Ļ▒┤ņØä Ļ░ĆņāüĒÖśĻ▓ĮņŚÉņä£ ĻĄ¼ĒśäĒĢśņŚ¼ ĒśäņŗżņäĖĻ│ä ņĀüņÜ®ņØä ņ£äĒĢ£ ļ¼╝ļ”¼ņĀü Ļ│ĄĻ▓®ņØś ĒÜ©Ļ│╝ļÅäļź╝ Ē¢źņāüņŗ£ĒéżĻ│Ā ņĀüļīĆņĀü ņØĖĻ│Ąņ¦ĆļŖź ļīĆņØæĻĖ░ņłĀņØś ĒÜ©ņ£©ņĀü Ļ░£ļ░£ņØä ņ£äĒĢ£ ņĀüļīĆņĀü Ļ│ĄĻ▓®/ļ░®ņ¢┤ ļ¬©ļŹĖ Ļ░£ļ░£ņÜ® ņŗ£ļ«¼ļĀłņØ┤ņģśņŚÉ Ļ┤ĆļĀ© ņŚ░ĻĄ¼ļÅä ĒĢ©Ļ╗ś ņłśĒ¢ēĒĢśņśĆņ£╝ļ®░ Fig. 12ņŚÉņä£ņÖĆ Ļ░ÖņØ┤ CG ĻĖ░ļ░ś CARLA ņŗ£ļ«¼ļĀłņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢśņŚ¼ ĒŖ╣ņĀĢ ĒģŹņŖżņ▓ś Ēī©Ēä┤ņØä ņ¦ĆņĀĢĒĢ£ Ēü¼ĻĖ░ļ¦īĒü╝ ļ░śļ│ĄņĀüņ£╝ļĪ£ ņ░©ļ¤ēņŚÉ ņĀüņÜ®ĒĢśĻ│Ā ļŗżņ¢æĒĢ£ ĒśäņŗżĒŖ╣ņä▒ņØś ļ░śņśüļÅä Ļ░ĆļŖźĒĢśļÅäļĪØ ĒĢśņŚ¼ ĒÜ©Ļ│╝ņĀüņØĖ ļ¼╝ļ”¼ņĀü Ļ│ĄĻ▓®ņØ┤ Ļ░ĆļŖźĒĢ©ņØä ĒÖĢņØĖĒĢśņśĆļŗż[28-32].

ĻĄ░ņÜ®ļ¼╝ņ▓┤ĒāÉņ¦Ć ņŚ░ĻĄ¼ņÜ® ĒĢÖņŖĄļŹ░ņØ┤Ēä░ ĻĄ¼ņČĢņØä ņ£äĒĢ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ņāØņä▒ĻĖ░ņłĀ ņŚ░ĻĄ¼ļź╝ ņłśĒ¢ēĒĢśņśĆļŗż. Ļ░ĆņāüļŹ░ņØ┤Ēä░ ĻĖ░ļ░ś ļöźļ¤¼ļŗØ ņŚ░ĻĄ¼ļź╝ ĒåĄĒĢ┤ ĒĢÖņŖĄņŚÉ ĒÜ©Ļ│╝ņĀüņØĖ ļŗżņ¢æĒĢ£ ņĪ░ļ¬ģņĪ░Ļ▒┤, ļ¼╝ņ▓┤ņ£äņ╣ś ļō▒ņØś ņŚ¼ļ¤¼ Ļ░Ćņ¦Ć ļ│ĆĒśĢņĪ░Ļ▒┤ņÜĖ ņāØņä▒ĒĢĀ ņłś ņ׳ņŚłņ£╝ļ®░ Ļ░Øņ▓┤ĒāÉņ¦Ć ļ░Å ņŗ¼ņĖĄņŗĀĻ▓Įļ¦Ø ņĀüļīĆņĀü Ļ│ĄĻ▓®ņŚ░ĻĄ¼ņÖĆ Ļ░ÖņØĆ ņØæņÜ®ļČäņĢ╝ņØś ļŹ░ņØ┤Ēä░ ņāØņä▒Ļ│╝ ļöźļ¤¼ļŗØ ļ¬©ļŹĖņØś ĒĢÖņŖĄņØ┤ Ļ░ĆļŖźĒĢ©ļÅä ĒÖĢņØĖĒĢĀ ņłś ņ׳ņŚłļŗż. ĻĄ░ņÜ®ļ¼╝ņ▓┤ ĒāÉņ¦ĆņÜ® Ļ░ĆņāüļŹ░ņØ┤Ēä░ļź╝ ņé¼ņÜ®ĒĢśņŚ¼ ļöźļ¤¼ļŗØ ļ¬©ļŹĖņØä ĒĢÖņŖĄņŗ£ņ╝░ņØä Ļ▓ĮņÜ░ ļŗ©ņØ╝ļ¼╝ņ▓┤ ĻĖ░ļ░ś ļ¼╝ņ▓┤ĒāÉņ¦Ć ņĀĢĒÖĢļÅä 85 %ļź╝ ņ¢╗ņØä ņłś ņ׳ņŚłņ£╝ļ®░ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ĻĖ░ļ░ś ņŗ£ļ«¼ļĀłņØ┤ņģś ņŚ░ĻĄ¼ļź╝ ĒåĄĒĢ┤ ņŗ¼ņĖĄņŗĀĻ▓Įļ¦ØņŚÉ ļīĆĒĢ£ ņĀüļīĆņĀü ĒĢÖņŖĄņØä ņ£äĒĢ£ Ļ│ĀĒÆłņ¦łņØś ļŹ░ņØ┤Ēä░ņÖĆ ļŗżņ¢æĒĢ£ ĒśäņŗżĒŖ╣ņä▒ņØä ļ░śņśüĒĢ£ ļ¼╝ļ”¼ņĀü Ļ│ĄĻ▓®Ēī©Ēä┤ņØä ņāØņä▒ņŚ░ĻĄ¼Ļ░Ć Ļ░ĆļŖźĒĢ©ņØä ĒÖĢņØĖĒĢśņśĆļŗż. Ē¢źĒøä ļŗżņżæļ¼╝ņ▓┤ ļ░Å ņåīĒśĢļ¼╝ņ▓┤ ĒāÉņ¦Ć ļō▒ņØä ņ£äĒĢ£ Ļ│ĀļÅäĒÖöļÉ£ Ļ░ĆņāüļŹ░ņØ┤Ēä░ ĒĢÖņŖĄ ļ░®ļ▓ĢļĪĀņŚÉ ļīĆĒĢ£ ĒøäņåŹņŚ░ĻĄ¼ņÖĆ ņŗżņĀ£ ļŹ░ņØ┤Ēä░ņØś ĒŖ╣ņä▒ņØä ļ│┤ļŗż ļŹö ņל ļ░śņśüĒĢĀ ņłś ņ׳ļÅäļĪØ Ļ░ĆņāüļŹ░ņØ┤Ēä░ņØś ļČäĒżļź╝ ņĄ£ņĀüĒÖöĒĢśņŚ¼ ļÅäļ®öņØĖĻ░äņØś ņ░©ņØ┤(Domain Gap)ļź╝ ņżäņØ┤ĻĖ░ ņ£äĒĢ£ ņČöĻ░ĆņŚ░ĻĄ¼Ļ░Ć ĒĢäņÜöĒĢĀ Ļ▓āņ£╝ļĪ£ ĒīÉļŗ©ļÉ£ļŗż.

REFERENCES

[1] S. I. Nikolenko, "Synthetic Data for Deep Learning," Springer Optimization and Its Applications 174, 2021.

[2] A. Tsirikolou, "Synthetic Data for Visual Learning: A Data-Centric Approach," "Linkoping Studies in Science and Technology Dissertation No. 2202," Linkoping University, 2022.

[3] Andrej Karpathy, "AI for Full-Self Driving at Tesla," ScaledML Conference, 2020.

[4] Todos os direitos reservados ao Blog do D├®rcio, V├ŹDEO: cidades de Oregon, nos EUA, t├¬m c├®u vermelho devido aos inc├¬ndios florestais, September 2020.

[5] C. Bressiani Vieira de Rocco, "Synthetic Dataset Creation for Computer Vision Application: Pipeline Proposal," Dissertation, Pontifical Catholic University of PArana Polytechnic School, 2021.

[6] A. Tsirikoglou, G. Eilertsen and L. Unger, "A Survey of Image Synthesis Methods for Visual Machine Learning," Computer Graphics forum, Vol. 39, No. 6, pp. 426ŌĆō451, 2020.

[7] D. Schraml, "Physically based Synthetic Image Generation for Machine Learning: a Review of Pertinent Literature," Proceedings of SPIE 11144, Sept. 2019.

[8] ImageNet, Download ImageNet Data, https://image-net.org/download-images. 2020.

[9] Open Images Dataset V4, Subset with Bounding Boxes(600 classes) and Visual Relationships, https://storage.googleapis.com/openimages/web/download_v4.html. 2019.

[10] NVIDIA, DEEP LEARNING SOFTWARE(SDK), https://www.nvidia.co.kr/content/apac/event/kr/deep-learning-software.

[11] Gartner, "Estimated by Access Ventures," Gartner Report, 2022.

[12] Gartner, Gartner Emerging Technologies and Trends Impact Radar, 2023.

[13] G. Nam, G. Choi, K. Park, E. Kim and S. Oh, "Synthetic-to-Real Generalization for Object Detection," KIMST Annual Conference Proceedings, pp. 906ŌĆō907, 2021.

[14] J. Tremblay et al, "Training deep networks with synthetic data: Bridging the reality gap by domain randomization," CVPR 2018 Workshop on Autonomous Driving, 2018.

[15] A. Prakash et al, "Structured domain randomization: Bridging the reality gap by contextaware synthetic data," arXiv:1810.10093, 2018.

[17] S. Oh, H. Yang, J. Kim, G. Choi and G. Nam, "Synthetic Image Generation for Deep Learning Projects," KIMST Annual Conference Proceedings, pp. 1305ŌĆō1306, 2022.

[18] K. Park, H. Lee, H. Yang and S. Oh, "Improving Instance Segmentation using Synthetic Data with Artificial Distractors," 20 th International Conference on Control, Automation and Systems(ICCAS 2020), pp. 22ŌĆō26, 2020.

[19] E. Kim, K. Park, H. Yang and S. Oh, "Training Deep Neural Networks with Synthetic Data for Off-Road Vehicle Detection," 20 th International Conference on Control, Automation and Systems (ICCAS 2020), pp. 427ŌĆō431, 2020.

[20] H. Yang, K. Ryu and S. Oh, "Learning Deep Object Detectors from Synthetic Data," KIMST Annual Conference Proceedings, pp. 699ŌĆō700, 2019.

[21] S. Oh, K. Ryu and H. Yang, "Optimal Experimental Design for Efficient Image Segmentation," KIMST Annual Conference Proceedings, pp. 697ŌĆō698, 2019.

[22] H. Yang, K. Ryu and S. Oh, "Improving Deep Learning based Object Detection with Synthetic Data," KIMST Annual Conference Proceedings, pp. 1157ŌĆō1158, 2019.

[23] H. Yang, K. Ryu and S. Oh, "Cross-Domain Image Translation for Large Shape Transformation using Generative Adversarial Networks," Korea Computer Congress, 2018;Vol. 1, pp. 800ŌĆō801, 2018.

[24] Y. Zhang et al, "CAMOU: Learning Physical Vehicle Camouflages to Adversarial Attack Detectors in the Wild," ICLR, 2019.

[25] T. Wu et al, "Physical Adversarial Attack on Vehicle Detector in the CARLA Simulator," CoRR, Vol. abs/2007.16118, 2020.

[26] J. Wang et al, "Dual Attention Suppression Attack: Generate Adversarial Camouflage in Physical World," CVPR, 2021.

[27] D. Wang et al, "FCA: Learning a 3D Full-coverage Vehicle Camouflage for Multi-View Physical Adversarial Attack," AAAI, 2022.

[28] N. Suryanto, Y. Kim, H. Kang, H. T. Larasati, Y. Yun, T. T. H. Le, H. Yang, S. Oh and H. Kim, "DTA: Physical Camouflage Attacks using Differentiable Transformation Network," CVPR, 2022.

[29] J. Kim, H. Yang and S. Oh, "Camouflaged Adversarial Patch Attack on Object Detecotr," Journal of the Korea Institute of Military Science and Technology, Vol. 26, No. 1, pp. 44ŌĆō53, 2023.

[30] S. Oh, H. Yang and J. Kim, "Simulation of Physical Adversarial Attack on Object Detection Models," KIMST Annual Conference Proceedings, pp. 589ŌĆō590, 2022.

[31] H. Yang, S. Oh and J. Kim, "Physical Adversarial Attacks on Object Detection Models," KIMST Annual Conference Proceedings, pp. 1303ŌĆō1304, 2022.

[32] H. Yang, S. Oh and J. Kim, "Threat of 3D Physical Adversarial Attacks on Deep Learning Models," KIMST Annual Conference Proceedings, pp. 595ŌĆō596, 2022.

- TOOLS

-

METRICS

-

- 0 Crossref

- 163 View

- 11 Download

- Related articles in J. KIMS Technol.

-

A Study on the Armor Optimization of Military Vehicle2013 August;16(4)

A Study on the Robot Teleoperation for Mine Removal2008 December;11(6)