[1] Jongho Shin and Sanghyun Joo, "NN-based Adaptive Control for a Skid-Type Autonomous Unmanned Ground Vehicle," Journal of Institute of Control, Robotics and Systems, Vol. 20, No. 12, pp. 1278–1283, 2014.

[2] S. Y. Kim et al, "Neural Network for a Roll Control of the Underwater Vehicle," KIMST Annual Conference Proceedings, pp. 14–15, 2018.

[3] H.-J. Chae et al, "Time-varying Proportional Navigation Guidance using Deep Reinforcement Learning," Journal of the Korea Institute of Military Science and Technology, Vol. 23, No. 4, pp. 399–406, 2020.

[4] S. Y. Kim et al, "Reinforcement Learning for a Roll Control of the Unmanned Underwater Vehicle," Naval Ship Technology & Weapon Systems Seminar Proceedings, pp. 474–477, 2019.

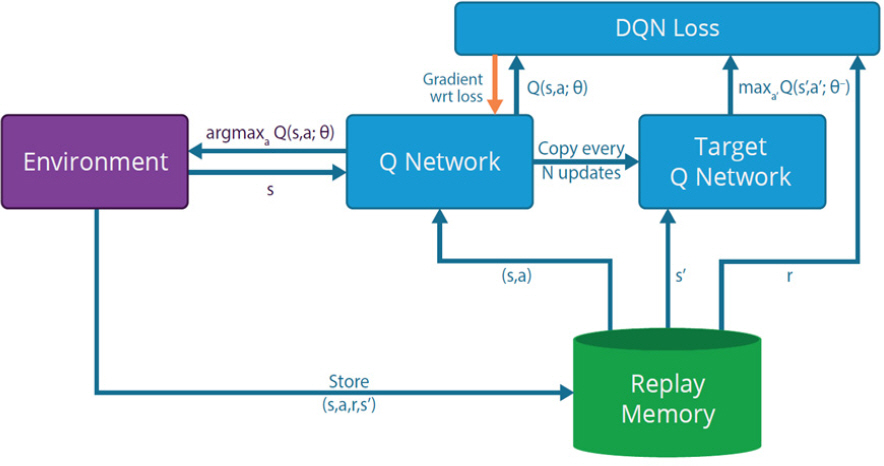

[5] Volodymyr Mnih et al, "Playing Atari with Deep Reinforcement Learning," In NIPS Deep Learning Workshop, 2013.

[6] Hado van Hasselt et al, "Deep Reinforcement Learning with Double Q-learning," AAAI, Vol. 16, 2016.

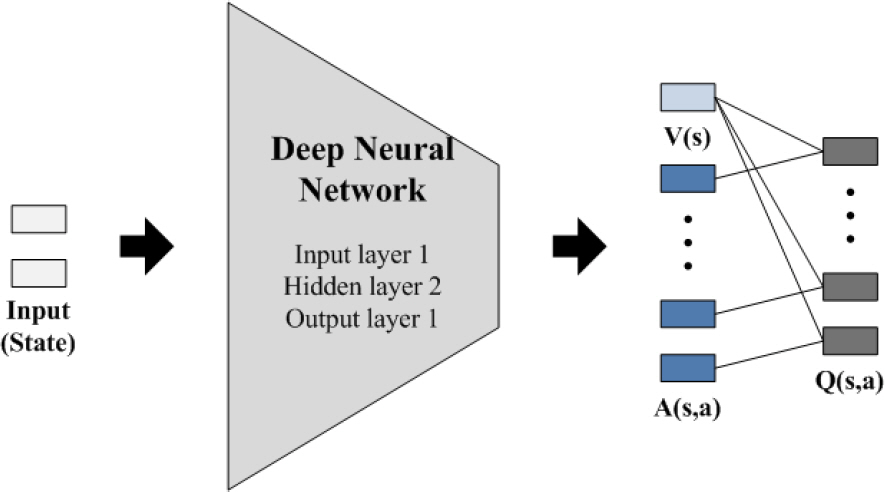

[7] Ziyu Wang et al, "Dueling Network Architectures for Deep Reinforcement Learning," Proceedings of The 33rd International Conference on Machine Learning, 2016.

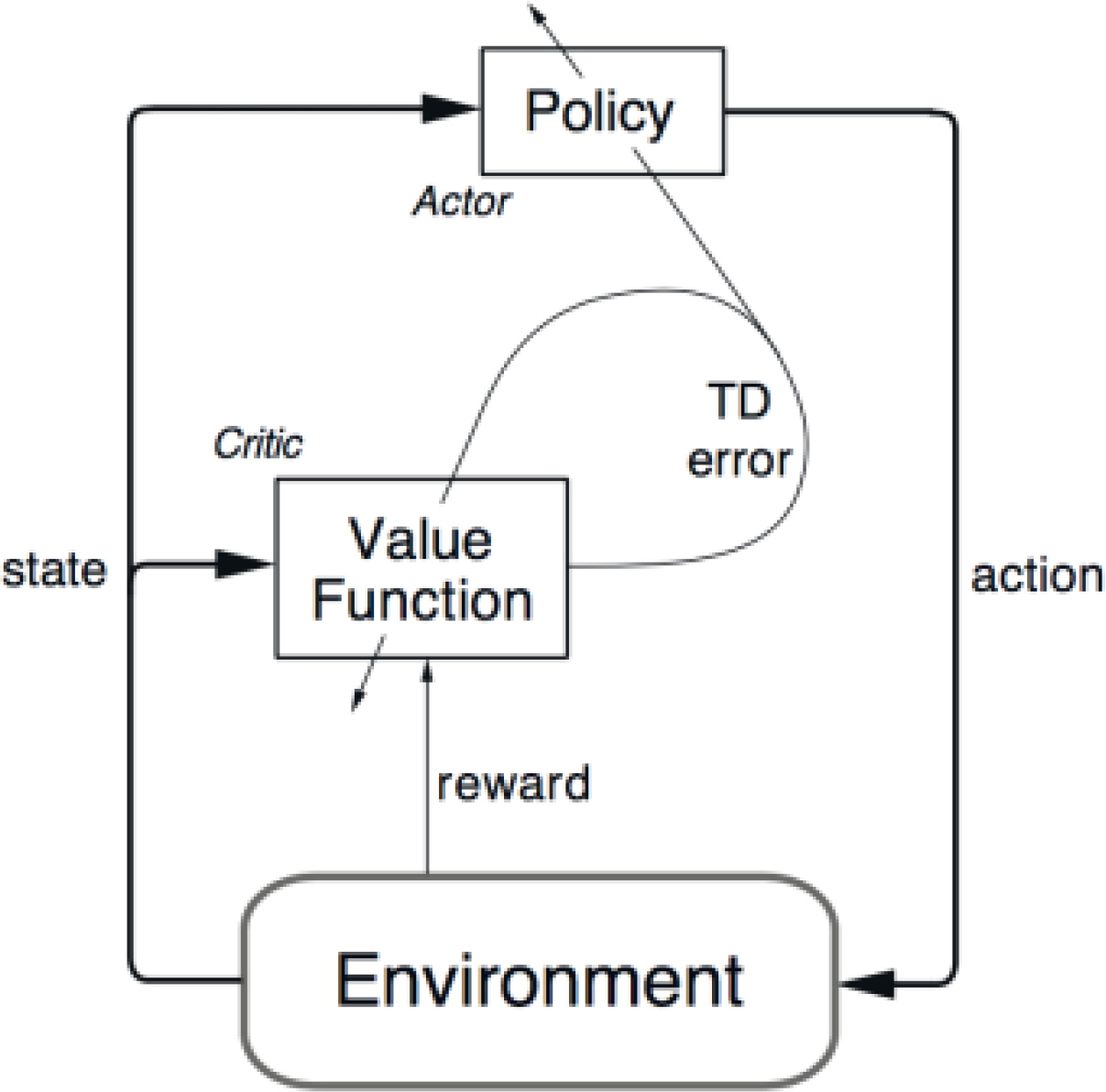

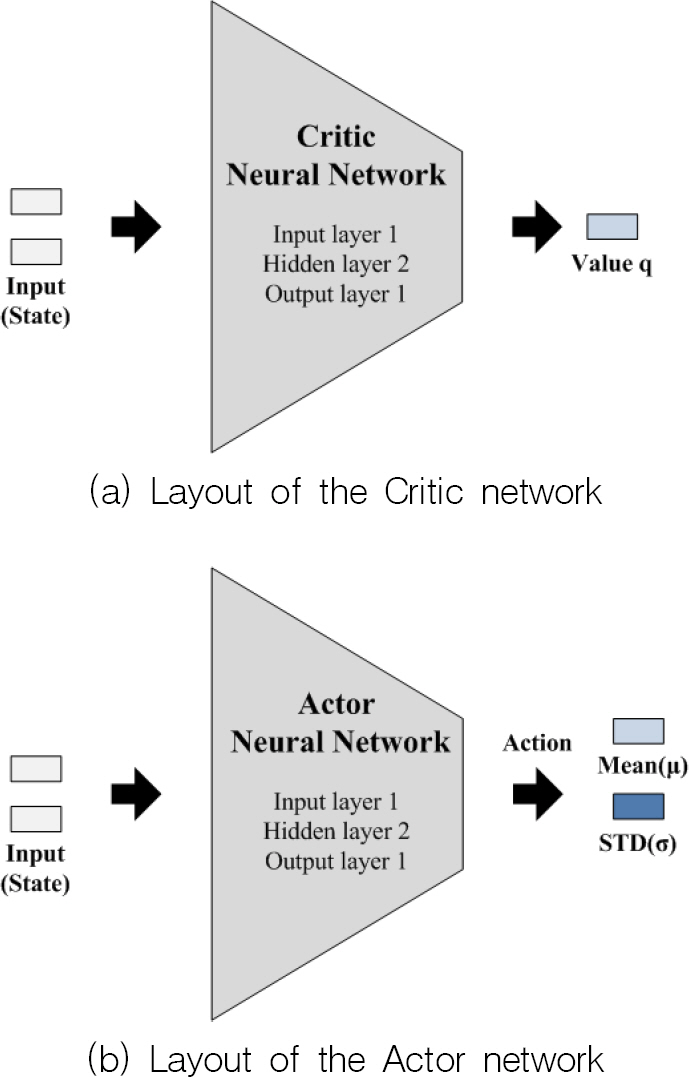

[8] R. S. Sutton and A. G. Barto, "Reinforcement Learning: An Introduction," The MIT Press, p. 328–333, 2018.

[9] W. W. Lee et al, "Reinforcement Learning with Python and Keras," Wikibook, p. 225–277, 2020.

[10] H. J. Cho et al, "A Two-Stage Initial Alignment Technique for Underwater Vehicles Dropped from a Mother Ship," International Journal of Precision Engineering and Manufacturing, Vol. 14, No. 12, pp. 2067–2073, 2013.

[11] Arun Nair et al, "Massively Parallel Methods for Deep Reinforcement Learning," In ICML Deep Learning Workshop, 2015.

[12] S. Y. Kim et al, "Robust Depth Control for an Autonomous Navigation of the Underwater Vehicle," KIMST Annual Conference Proceedings, pp. 14–15, 2013.

[13] Benjamin C. Kuo, "Automatic Control Systems," Prentice Hall, 1994.